Señora si ahora salido que está

grabando buenas tardes,

bienvenidos.

Bienvenidas a esta conferencia

que hemos organizado desde el

Vicerrectorado de Investigación

con motivo del 20.

Aniversario de la Comisión de Ética

de Investigación de la Universidad de

Murcia.

Hemos realizado ya otras

conferencias a lo largo de este año

y hoy tenemos el honor y el placer

de leer con nosotros.

Ha hecho sin que el científico

titular

en el Instituto de Filosofía del

Grupo de Ética Aplicada sea doctor

en Filosofía por la Universidad

del País Vasco,

premio con Premio Extraordinario,

profesor invitado en varias

universidades

y colaborador en el Instituto

de Gobernanza Democrática.

Sus áreas de trabajo son

la ética pública,

la bioética,

los derechos humanos y la filosofía

de las tecnologías disruptivas

es miembro del OS de.

Data o forzosa,

el Economic editor editoria autor de

varias obras sobre estos temas,

ha sido fundador de la revista

electrónica aplicada dilema,

y en la actualidad forma parte de

los equipos de investigación

de este, que significa,

bidireccional neural.

Existen datos en salud de la

Fundación Séneca de Murcia,

detección y eliminación de ese

en algoritmos de triaje

y localización para la 9, desde

la Fundación BBVA Bazar.

Va Karzai soledad no deseada y

cuidados que está auspiciado

por BBK, Cunha, presidente

del comité de ética

de este.

Sí colabora también en la red

espacio o estética, salud vista

para la acción, cuidados

y observación social,

y en el cluster de ética

del País Vasco.

Bienvenido, querido amigo, hecho.

Si considera que estás en tu casa,

que además tienes una

intensa relación

con la Universidad de Murcia

a través del cerebro

es a través de nuestro centro

de estudios en Derecho

y por lo tanto, para nosotros eres

una persona muy cercana,

muy querida y desde luego

pues estamos encantados

de tener esta tarde para hablar

de la ética en relación

con los robots y la inteligencia

artificial

así que tienen la palabra

gracias techo

pero que si recibes la presentación

envidio eso me siento en casa

porque para mí Murcia y el centro

de estudios de Derecho Salud,

pues es como un segundo hogar.

De hecho, los constituidos

recientemente,

una unidad asociada entre sí

el Instituto de Filosofía

y cual formó parte,

así que me hubiera acto participar

en este ciclo,

también la vicerrectora

de Investigación,

la invitación a este ciclo de

conferencias que celebran

el conmemorar el vigésimo

aniversario de la Comisión de Ética

de la investigación de la

Orquesta de Murcia

que hasta donde yo sé creo que es

la decana de las comisiones

de investigación ética de la

investigación de España,

formó parte del comité de ética del

csic, que ha cumplido 15 años,

que llevamos 20, son más, así que

desde luego felicitaciones,

y la verdad es que es un

hito muy importante

y me alegra mucho participar

en este ciclo.

El título de la presentación

de la comunicación era para convivir

con la inteligencia artificial,

y lo que les quiero plantear

es un poco

cuál es, cuáles son importantes

la ética

en esta nueva convivencia, con

la inteligencia artificial,

y lo voy a empezar por

la palabra convivir,

porque podríamos preguntarnos

que igual es exagerado

hablar de ello,

pero es evidente que cada vez

más estamos constituidos,

como sistema socio técnicos,

donde hay una continuidad en cierto

modo entre lo humano

y la tecnología.

La tecnología no es un elemento

separado de la sociedad

y, como decía Ortega y Gasset, no

vivimos con la tecnología,

sino que vivimos en la tecnología.

La mayor parte de nuestro

mundo es artificial

y los seres humanos interactúan,

con los artefactos en una

suerte de simbiosis,

lo que se conoce como HDMI

fuman, sin trecho,

donde se difumina las fronteras

entre los sujetos humanos

y la tecnología.

De algún modo constituimos lo

que los tecnólogos llaman

Sistemas Murcia,

gentes, donde será una especie

de agencia compartida,

y muchos de ellos prefieren hablar,

no de inteligencia artificial,

sino de inteligencias compartidas

y colectivas.

No, porque estamos en esta suerte de

interacción con las máquinas.

De hecho podemos decir que todas

nuestras interrelaciones

están mediadas tecnológicamente.

Mantenemos una interacción

física, cognitiva,

emocional con la tecnología.

Pensemos en esa relación casi

patológica que tenemos,

con nuestros teléfonos móviles

y hay una patología que se

llama la nomofobia,

ese miedo a estar desconectado

a salir de casa,

sin el teléfono móvil,

o aquello que se presentaba en

una película de pero bonita,

donde el protagonista

Fénix se enamoraba

de una inteligencia artificial,

por eso quiere decir que

que mantenemos éste

esta simbiosis y por eso

también valores

que tradicionalmente está reservado

a los seres humanos,

como la autonomía, la

responsabilidad la vida de alguna manera

empezamos a proyectarnos también

entidades tecnológicas híbridas,

que constituimos con la tecnología.

Y por qué es?

Porque hasta entonces en todas partes

no yo lo llamo el internet del todo,

porque la inteligencia artificial

se basa en una explosión de

artefactos e instrumentos

que están altamente interconectados

y que recogen enormes cantidades de

datos de información a través,

por ejemplo, de sensores

que están incorporados

en infinidad de objetos cotidianos.

No solo nuestros teléfonos móviles,

sino el ordenador,

a través del cual estamos hablando

ahora los televisores,

los automóviles, los

electrodomésticos es decir,

todo lo que se conoce como el

Internet de las cosas,

pero también podríamos hablar

de internet de los cuerpos,

porque nuestro propio cuerpo se ha

convertido en una plataforma

tecnológica a través, por ejemplo,

de dispositivos médicos,

de implantes, de una

pulsera o un reloj

que mide nuestras pulsaciones

y nuestra forma física

a través de lo que se conoce ahora

como los medicamentos digitales

que se incorporan se ingieren.

Nuestro cuerpo incorpora

un tipo de dispositivo

y luego, además, hay que decir que

toda esta enorme cantidad

de interacciones de datos

que se recogen se hacen muchas veces

también fuertes de fuentes abiertas

de transacciones que realizamos

a través de una aplicación

o de nuestros dispositivos,

o nuestra participación en redes

sociales, etc. Incluso,

simplemente cuando estamos paseando

existen sistemas

de reconocimiento facial de

escáneres de huellas dactilares,

es decir, cada vez hay una mayor

ratificación de la realidad

y por eso me refiero a una internet

del todo la inteligencia artificial

y la robótica social que es a

la que me voy a referir.

También hay un asunto sobre

cuál me voy a referir más

adelante es el de las muchas manos

y muchas cosas conectadas,

y esto tiene una implicación directa,

por ejemplo sobre la noción

ética y jurídica,

también de responsabilidad,

como podamos atribuir la

responsabilidad en entornos

donde existen esas interacciones

esa esa hibridación

entre lo tecnológico y lo humano es

el problema de las muchas manos,

muchas cosas conectadas.

Bueno, desde un punto de

vista filosófico,

este contexto, esta convivencia

con las máquinas

supone una ratificación

de la realidad.

Podemos decir que lo que es

real es la información.

Todo se transforma.

En datos cuantificables, ya he dicho

que se cuantifican todas

nuestras interacciones humanas,

los pensamientos,

los estados de ánimo

de comportamiento,

a través del análisis de

elementos intangibles

de nuestra vida cotidiana,

que se pueden monitorizar a través

de los gráficos sociales

que estudian las redes

sociales Twitter,

Facebook, LinkedIn, etc. Pero

también se ha ratificado

los actos más esenciales de

nuestra de nuestra vida,

el sueño, la actividad física,

la presión sanguínea,

la respiración tenemos cada vez más

elementos de monitorización,

prendas de vestir, píldoras

digitales,

como he dicho antes, dispositivos

de implante cerebral,

relojes inteligentes,

prótesis que están recogiendo

constantemente datos

y que de alguna manera nos

configuran como un yo cuantificado,

pero también se cuantifica

y se ratifica el espacio

a través de la geolocalización,

y, como he dicho antes,

a través de las objetos se siguen

recogiendo constantemente.

Infinidad de cantidades de datos y

claro, todos estos, estos datos,

se utilizan y se se monetiza porque

también son un negocio

a través de algoritmos,

un algoritmo que parece una

palabra sin muy novedosa

es algo muy antiguo.

No deja de ser una lista más o menos

larga de instrucciones;

un conjunto ordenado

y de pasos que puede emplearse

para hacer cálculos

para resolver problemas y alcanzar

decisiones en un algoritmo

es un estado inicial y una entrada

siguiendo una serie de pasos se

llega a un estado final y se obtiene

un resultado eso es simplemente

un algoritmo,

lo que pasa es que es verdad

que todo este proceso

de recogida ingente de datos

se ha facilitado mucho,

con los teléfonos inteligentes, la

tecnología de computación barata

y porque tenemos eso, los equipos

procesadores digitales

y el almacenamiento para

manejar y utilizar

esta enorme cantidad de datos y a la

vez tenemos las herramientas,

son las estadísticas, algoritmos

a la vez en paralelo,

tenemos un desarrollo de lo que

también era una disciplina clásica,

era la robótica.

Al final, un Renault es

una máquina situada

en el mundo que siempre era una

manera piensa y actúa,

y tiene 3 elementos característicos.

Tiene unos sensores que le permiten

percibir información del entorno

del contexto, tiene una capacidad

de procesamiento

de información que le permite

emular algunos aspectos

de la condición humana y

sacar esa capacidad

de procesamiento.

Es la que está vinculada a la

inteligencia artificial,

y lo tiene también lo que se conoce

como unos actuadores, es decir,

algunos elementos que le permiten

interactuar en el entorno

pueden ser brazos artificiales,

ruedas, algún tipo de mecanismo,

que es lo que ha cambiado en

el ámbito de la robótica,

pues es que la robótica clásica

se limitaba a, por un lado,

a estar en espacios restringidos,

por ejemplo, en la industria,

y estaba de alguna manera

perfectamente controlado,

y se basaba en lo que se conoce como

algoritmos, determinista,

es decir,

con un conjunto de de pasos que eran

perfectamente indefinible

y predecibles.

Mientras que los algoritmos

de la robótica actual.

Son algoritmos que se

llaman cognitivos,

no porque desarrollan eso

capacidades de aprender del entorno,

y dependen mucho de esa interacción

que establecen con el entorno.

Es el caso de la robótica

interactiva o social que de alguna manera

opera directamente en un entorno

que es cambiante,

que es complejo, que es impredecible

y en el cual se encuentra

el ser humano y nosotros

interactúa con ésta,

con esta robótica.

Hay un documental que

pueden consultar,

que está en YouTube, en abierto,

que realizó un compañero de nuestro

grupo de investigación,

del Grupo de Ética Aplicada del

Instituto de Filosofía,

Daniel López, que se titula Si se

aparecen los robots están saliendo

de las fábricas y se pregunta

estamos preparados

y es una serie de reflexiones

que nuestro compañero

recogió en laboratorios

de toda Europa

sobre cómo está transformando

el sentido de esa robótica,

esa nueva robótica, que son robótica,

que está en una interacción mucho

más directa con los seres humanos;

por lo tanto, tenemos esta

explosión de artefactos,

esta inteligencia artificial,

basada en datos que alimenta

también otros artefactos,

que están ya en nuestro entorno en

un entorno que es cambiante,

que es complejo y en el cual nos

situamos los seres humanos,

y esto genera una serie de riesgos.

Como pueden pueden imaginarse,

voy a mencionar algunos

de los más evidentes,

el riesgo, que se conoce muy bien,

sobre la privacidad de las personas

y también con la posibilidad de

manipulación o el estrecho contacto

de estos artefactos y estos

sistemas cognitivos,

con las personas a través de

dispositivos implantes,

pueden favorecer la intervención

coercitiva de las mentes

y posibilitar el que se conoce

como el troquelado.

Son la manipulación

éste es un riesgo evidente también

relacionado con esto,

está el riesgo de la cancelación

de la identidad

y otro tipo de fraudes, relacionados

con la suplantación,

que puede propiciar la inteligencia

artificial

y la robótica interactiva.

Asimismo está el problema del engaño

porque este tipo de tecnologías

pueden propiciar falsas relaciones

auténticas,

en la medida en que se construyen

entornos cuya finalidad

puede ser instrumentalizar

de algún modo

los individuos que pueden;

por ejemplo, acabar dependiendo

emocionalmente

de este tipo de tecnologías de

robots e inteligencia artificial,

que es un poco lo que pasaba

en la película.

También otros riesgos, la merma

de contacto humano,

la robótica, la interactiva

y la inteligencia

artificial pueden contribuir

al deterioro

de las relaciones interpersonales,

propiciando el aislamiento social

y una pérdida de la interacción

social significativa.

Haré mucho mucha reflexión

al respecto,

por ejemplo, sobre lo que significa

el metaverso no esta nueva realidad,

que se está proponiendo unos

escrito recientemente, un,

articular aspecto también

sobre lo que

significa también de aislamiento, de

interacción social significativa,

y aunque hay discusión, parece

que los estudios apuntan

a que las relaciones interpersonales

presenciales, por ejemplo,

esta misma Conferencia, hubiera

sido mucho más grata y mucho

más interesante si hubiera podido

realizarse presencialmente,

que no nos imponen ya restricciones,

por ejemplo,

de la pantalla de nuestra banda,

que tengamos nuestra conectividad

de nuestro lugar

y que digamos, no porque

tengamos mejor o peor,

cobertura, etc. También

en las relaciones

con las tecnologías, por ejemplo,

con la robótica interactiva,

cuando se aplica por ejemplo

los entornos de cuidado

está el riesgo de la realización

de los individuos

y, por tanto, la devaluación

de su dignidad,

algo que puede ir acompañado

de cierta estigmatización

y infantilización de un colectivo

de usuarios de.

Con respecto a este tipo

de tecnologías

y también en última instancia,

esta tecnología

puede producir una reducción de

las relaciones a una ilusión,

no con lo que supone de limitación

de nuestra propia vida,

y nuestra propia comprensión,

como como seres humanos,

no pueden conducir a una

cierta deshumanización

y, por ejemplo, en el

caso del cuidado.

Pueden erosionar el mismo

sentido del cuidado

como una práctica moral

relacional esencial?

Bueno, y además hay que decir que

estos escenarios planteados

son especialmente relevantes también

para grupos individuos vulnerables

como pueden ser menores adolescentes

personas con diversidad funcional

personas mayores

no en cuyo caso hay que tener una

consideración muy específica

con respecto a estos individuos

y colectivos.

No, este es un poco el mapa

de la situación.

Convivimos con la tecnología,

existen unos riesgos que podemos

calificar de importantes

y en algún sentido existenciales,

y por eso se ha planteado una, una

reflexión ética al respecto,

y la verdad es que existen ya un

montón de análisis muy variados,

de recomendaciones de documentos,

de guías,

se han descontado ya más

de 90 a nivel global

sobre el impacto de estas

tecnologías,

lo cual, por un lado, muestra

el interés que suscitan,

aunque por otro lado, también

generan a veces ruido y confusión.

Si 1 analiza los principios

de las principales declaraciones, no

como los principios de asilo Mar,

la Declaración de Montreal para

una inteligencia artificial,

responsable, los documentos que ha

generado el Instituto para la

Ingeniería Electrónica eléctrica

de Estados Unidos,

propuestas desarrolladas por

el grupo de expertos

de alto nivel en la Comisión Europea

sobre inteligencia artificial.

Al final algunos se puede, se

puede volver a sintetizar,

que estamos podemos considerar 5

principios éticos básicos a la hora

de abordar nuestra convivencia con

la inteligencia artificial

y la robótica social, que

son 5 principios,

que los 4 primeros coinciden

básicamente con los principios

más o menos clásicos de

las éticas aplicadas,

que también han sido utilizados

ampliamente en la bioética.

Simplemente ha adaptado

su poco este contexto

más un principio.

Cuáles serían esos principios,

ese marco ético mínimo

y Alavés general para abordar

esta nueva relación,

esta nueva convivencia, el

primero y más básico

sería el principio de no

más deficiencias.

La idea de minimizar los daños no;

lo primero fundamental

es no dañar, o sea,

no sólo con acciones intencionadas

sino también sobre la imposición

de riesgos.

Por lo tanto, son muy importantes

la prevención y la precaución,

y además hay que considerar tanto el

daño relativo a los individuos,

pero también a los colectivos,

como he dicho antes,

con especial atención a individuos

y grupos vulnerables,

y a riesgos que podríamos considerar

existenciales o sistémicos,

no que tienen que ver con nuestra

propia identidad,

con nuestra propia comprensión

como seres humanos.

Por lo tanto, el principio

de eficiencia

de minimizar los daños implica la

importancia de la seguridad

y de la ciberseguridad, entendida

como un valor social

que debe destacarse cuando

los seres humanos

interactúan con sistemas

de decisión delegada,

como son los sistemas de

inteligencia artificial

y la robótica social.

Por lo tanto, la seguridad

es muy importante.

También en este contexto de

minimizar los daños se que hay que prestar

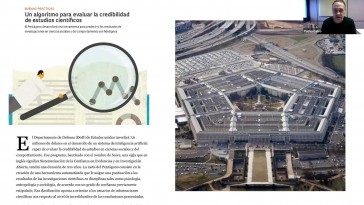

una especial atención a los sesgos

tanto en la recopilación de datos,

como en el manejo y el entrenamiento

de los algoritmos,

instrumentos de inteligencia

artificial y la robótica social,

los sesgos son, 1 de los problemas

más estudiados en este ámbito

de estas tecnologías, y no

dejan de ser prejuicios

en nuestro modo de procesar

la información

y, por tanto, un modo distorsionado

de percibir.

La realidad es la propensión

a beneficiar a un grupo,

perjudicar de manera justa o

éticamente inadmisible,

y estos sesgos dan lugar en las

inteligencias artificiales,

en la robótica social, la

discriminación por razón de sexo,

género, raza, estatus económico

consolidando prejuicios

y estereotipos existentes,

reforzando muchas veces

la exclusión social y

la estratificación.

Por lo tanto, son sesgos que dañan y

perjudican a individuos y grupos.

Ya hay muchos ejemplos que se

han estudiado, por ejemplo,

en el caso de sistema judicial

norteamericano, aquel programa compás

que perjudicaba sistemáticamente

a la población afroamericana

o en otros ámbitos,

como algunos sistemas de

reconocimiento facial,

pues estaban, por ejemplo, cargados

con con el consenso,

que discriminaban sistemáticamente

a las mujeres.

El primer principio sería

este principio básico,

un principio ético básico,

de minimizar los daños en eficiencia

correlativamente.

El segundo principio sería el

de buenas consecuencias,

maximizar los beneficios

o beneficencia,

y es que los beneficios potenciales

de estas tecnologías

deben superar el posible riesgo

para los sujetos,

las comunidades y el medioambiente,

y esto se relaciona de alguna manera

con la orientación hacia

el bien común

y hacia los Objetivos de

Desarrollo Sostenible.

Por eso, los tratamientos de

inteligencia artificial

y de robótica social deben acreditar

claramente su necesidad,

su efectividad y su orientación

al bien común,

acotando un propósito bien

definido y determinado,

es decir, tienen que ser

proporcionales.

Una buena práctica en el ámbito

de la tecnología

es evaluar previamente, si

realmente es necesario

desarrollar una tecnología

inteligencia artificial

o de robótica social para un

determinado contexto.

Problema a veces se acude

rápidamente a esta solución tecnológico,

cuando otro tipo de intervenciones

pueden ser mucho más acertadas,

mucho más sostenibles y mucho menor.

Impacto social,

ecológico, etc. Este por eso el

principio de beneficiencia

incluye la protección

del medio ambiente

y las generaciones futuras, y esto

es un asunto muy importante

que no se tiene en cuenta

muchas veces,

porque todo este desarrollo de

la inteligencia artificial

y de la robótica interactiva, tiene

un enorme impacto medioambiental.

Las infraestructuras vinculadas a la

misma inteligencia artificial,

los centros de datos y

de cálculo, que son,

que tienen materialidad y que

consumen enormes cantidades

de energía muchísimas derecho,

las propias empresas

están viendo que eso puede llegar

a ser una limitación importante

para su negocio.

Están trasladando sistemáticamente

sus centros de cálculo,

por ejemplo, a países fríos,

lugares fríos,

donde tienen que consumir

mucha menos energía.

Para refrigerar estos sistemas

también se estrena investigando,

denodadamente hardware sostenible

que produzcan menos calor que

consuman menos energía,

pero también hay que considerar la

extracción de materias primas

que es muy alta para desarrollar

estos sistemas,

y además sería una estación que se

hace a veces sin condiciones,

que no son especialmente justas

precisamente sobre esta cuestión

del impacto medioambiental,

y suben las generaciones futuras.

Se va a celebrar la semana

que viene en Bilbao

la primera conferencia

de los días 17 18

va a participar también en la Unidad

Asociada entre el CEBS

y el Instituto de Filosofía con

algunos vamos a participar

en este esta conferencia, donde

vamos a analizar las posibilidades

de alinear la transición digital

en la que estamos metidos,

y la transición energética en la

que también estamos metidos,

en la que, como estamos viendo,

esta está provocando muchísimos

problemas.

Por lo tanto, tenemos minimizar

los daños,

maximizar los beneficios.

El tercer principio ético sería

el de respeto y autonomía,

entendido como que los procesos

de inteligencia artificial

y robótica social han de estar

centrados en las personas

y amparar el derecho de

éstas a conservar,

la facultad de decidir

qué decisiones.

Tomar y ejercer la libertad de

elegir cuando sea necesario,

esto significa que los humanos

han de preservar el poder

de decidir en última instancia,

qué decisiones tomar

y cuál es delegar.

Existen más de datos e inteligencia

artificial y robótica social.

Esto es muy importante porque, como

he dicho antes, por ejemplo,

estos sistemas pueden vigilar

y modificar efectivamente,

el cerebro, afectando

al propio sentido

de autonomía e identidad

de las personas

y, en última instancia, a la

forma en que nos vemos

a nosotros mismos y nuestras

relaciones con los demás.

Por lo tanto, hay que tener

especialmente cuidado

con todos los sistemas que generan

patrones estadísticos recurrentes,

que pueden ser usados para preferir,

para predecir y entender el

comportamiento de las personas,

perfil y manipularlas emocionalmente.

Por todo ello, hay que proteger

a los individuos

contra el uso coercitivo

de estas tecnologías

y la posibilidad de que la

tecnología pueda ser utilizada

sin nuestro consentimiento.

Esto supone, por un lado,

proteger la privacidad y los datos

de carácter personal,

pues además también, como

decíamos antes,

con ciertas medidas de seguridad,

la fuga de datos,

la falta de transparencia en

la recogida de datos, etc.

Y luego también buscando a preservar

la identidad personal,

la continuidad del comportamiento

personal frente a modificaciones

no consensuadas de terceros.

Esto es un poco el debate que

hay en la actualidad.

Es un debate jurídico muy

interesante sobre la pertinencia

de introducir lo que se conoce como

los nuevos derechos humanos,

que protegerían de algún modo

la libertad cognitiva.

Otra terminación mental es el

derecho a la privacidad mental,

el derecho a la integridad mental

y el derecho a la continuidad

psicológica

Hay algunos algunas iniciativas

como la que ha liderado

el neurobiólogo español Rafael Yuste,

que trabaja en Columbia

y ha propuesto,

pues es una introducción

de las constituciones

o las cartas de derechos de

los derechos humanos

también dentro de algunos sectores

de la filosofía jurídica.

Es un debate interesante

sobre si es necesario no introducir

este tipo de derechos.

En cualquier caso, respecto

a la autonomía,

es un elemento ético importantísimo

en nuestra relación

con este tipo de tecnologías.

es el tercero.

El cuarto sería el principio

de justicia.

En el ámbito de la ciencia la

tecnología se puede interpretar,

se puede dividir en 2

cuestiones básicas.

Por un lado, digamos, el

reconocimiento y, por otro lado,

la asignación de recursos o

distribución de recursos escasos,

ya que me refiero con reconocimiento

me refiero a la inclusividad,

que supone tener en cuenta todos

los interesados y afectados,

la diversidad, la gente sí;

valores en el proceso en

proceso de desarrollo,

de tecnologías.

Incluso también consiste este

reconocimiento es respetar

a quienes quieren mantenerse, al

margen del plano analógico,

una colega, el Instituto de

Gobernanza Democrática,

mal una línea llamado el principio

de exclusión,

es decir, nadie tiene que estar

excluido, por ejemplo,

de su relación con la administración

o de determinados bienes sociales

por estar al margen del

mundo digital,

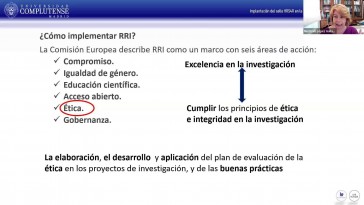

es decir, en cualquier caso, como

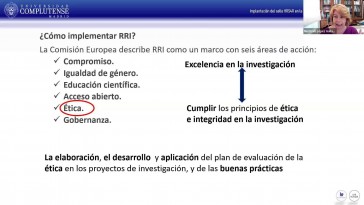

dice desde la perspectiva

de la investigación, innovación

responsable,

que creo que tuvieran además una

conferencia de un amigo y colega

Patrici Calvo, hablando poco de

la ética de la investigación

en estos ámbitos,

pues en todas las etapas de los

procesos de desarrollo,

de inteligencia artificial,

robótica social,

hay que tener en cuenta y utilizar

metodologías inclusivas

y participativas.

Esto es un elemento de la justicia

de reconocimiento

y el otro es el que tiene que ver

con la asignación de los recursos

y, por lo tanto, con la búsqueda de

la igualdad y la accesibilidad,

es decir, con equidad,

porque se debe evitar una nueva

brecha de desigualdad

a causa de la inteligencia

artificial y de la robótica social.

Quería existe actualmente

con la brecha digital,

por eso es muy importante impulsar

los algoritmos abiertos,

el conocimiento compartido

en estos ámbitos

para favorecer la solidaridad y la

distribución de los beneficios

de la tecnología, y esto

es muy importante

porque corremos el riesgo de generar

una nueva brecha de desigualdad

a cuenta de la introducción de

instrumentos de inteligencia

artificial y robótica social.

Estos 4 son, como les he dicho,

compartidos con otras técnicas

aplicadas también con la bioética

y aquí habría que introducir

un quinto elemento,

que es especialmente relevante

en el ámbito

de la inteligencia artificial,

y la robótica social,

basada en algoritmos de inteligencia

artificial,

y es la explica habilidad.

Hemos dicho que estas tecnologías son

especialmente impactan directamente

en nuestra vida cotidiana

y afectan a aspectos muy sensibles,

importantes desde la atención

sanitaria a los propios derechos

civiles y sociales,

desde el crédito a los seguros,

el derecho penal

y, por lo tanto en la medida en

que tienen esta este carácter

tan disruptivo, es muy importante

que puedan ser explicables.

Qué significa explicable, no

en el sentido técnico

sino en el sentido más ético

-filosófico.

Significa, por un lado,

que se pueda comprender de algún

modo su funcionamiento quizás no todo,

pero que sean procesos que en algún

sentido son inteligibles

y, sobre todo,

que se pueda identificar el

proceso de decisión,

las personas implicadas y las

consecuencias que se deriven,

es decir, que se puedan

rendir cuentas.

El gran riesgo de estos restos

de estas tecnologías

es lo que se conoce como

las cajas negras,

no aquello de que no se pueda

explicar y no se puedan pedir cuentas

a unos sistemas que no

se conoce como no.

Por eso la idea de comprensión

de interpreta habilidad

y de rendición de cuentas están

directamente ligadas

a este principio que se ha venido

en denominar explica habilidad.

Llama a este principio complementa

a los anteriores

porque para que un sistema de

inteligencia artificial

y robótica social sea ineficiente

y eficiente

debemos ser capaces de

entender el bien

o el mal que se puede producir

para que un sistema promueva

y no restrinja la autonomía,

la decisión de quien

decide la decisión

sobre quién decide debe estar

informada mediante el conocimiento

de cómo actuaría la inteligencia

artificial,

y nosotros tenemos que

ver cuáles nos pasos

que dar para que un sistema sea

justo y alguien se haga cargo,

y esto es muy importante desde

el punto de vista

de la responsabilidad de los

resultados negativos

en el caso de que los hubiera

precisa la rendición de cuentas

y por lo tanto es precisa esta

trazabilidad y comprensión

de por qué se han producido

estos resultados

cuando estamos antisistemas,

que son opacos,

no podemos tener ni rendición de

cuentas ni por lo tanto asunción

de responsabilidades y tampoco

conocimiento suficiente

para decidir qué dejamos

inteligencia artificial

y que no dejamos que se

pueden producir.

Por eso, este principio fundamental,

que de alguna manera repercute

condiciona los anteriores.

Estos 5 principios tenían el

marco del marco ético

para general.

Para hablar precisamente

de esta convivencia

con los robots sociales y con

la inteligencia artificial,

luego se pueden concretar en normas

de actuación en buenas prácticas.

La primera, de las cuales solo

voy a referirme a ella,

es esa que les comentaba.

Y es que hay

que valorar siempre previamente

la necesidad y conveniencia

de desarrollar una aplicación basada

en Inteligencia Artificial,

en datos masivos.

No hay que justificar de

manera convincente

la necesidad y pertinencia,

porque a veces si hacemos un análisis

el impacto medioambiental, la

posibilidad de discriminación,

el riesgo con respecto a la

autonomía de las personas,

una materia especialmente sensible

a la que se refiere,

pensemos, por ejemplo, en procesos

de justicia penal,

nos deberían hacer considerar

que no tenemos

que desarrollar un sistema de

inteligencia artificial,

robótica social, para esa,

para esa necesidad.

Por eso es muy importante determinar

y documentar claramente los

objetivos y el alcance del sistema o aplicación

y, sobre todo, establecer un marco

a través de lo que se conoce

como una evaluación de impacto

ético de todo proyecto,

y todos los servicios que se vaya a

basar en inteligencia artificial

y en robótica social.

Para evitar los sesgos, por tanto,

las discriminaciones,

para analizar el impacto

medioambiental,

para estudiar y destacar también

la participación

y la inclusividad que ese desarrollo

tiene con respecto al entorno

ni cuál se va a introducir

esta tecnología

o este sistema.

No voy a extenderme en estas

buenas prácticas

porque se pueden detallar muchas

que son resultado

de los principios a los que

me acabo de referir.

Precisamente en algunas

instituciones,

como por ejemplo, la Diputación

Foral de Gipuzkoa

está preparando un código

ético para los datos

y la inteligencia artificial

que quiere aplicar

y que quiere que sea el marco

de referencia para su plan

de transformación digital

y para el desarrollo de sus

propias aplicaciones

basadas en datos y en inteligencia

artificial.

Esto es muy importante

porque las instituciones tienen

un elemento tractor

y de ejemplaridad que puede

generar buenas prácticas,

también se relacionan.

Por lo tanto, sí podrían,

si me preguntan cuál es el alcance

de la ética para este marco ético,

para la convivencia con artefactos

basados en inteligencia artificial,

sociales es que la ética permite

alinear los valores

de la sociedad con las tecnologías,

como la inteligencia artificial,

de modo que se genere innovación

y apropiación social

de dicha tecnología mediante

que mediante la confianza

la ética son un elemento

indispensable

para generar confianza, y para

propiciar estos entornos

que ya nos constituyen

socio -técnicos,

que sean de alguna manera inclusivo

como decía filósofo en la ciencia

de la ministra de Salamanca, que

sean entornos étnicos entrañables

una palabra que lo traducen

como entrañable,

sin una palabra, entrañable

que es un entorno social

técnico entrañable, un entorno

que es abierto,

que es versátil, interoperable, que

es controlable, que es comprensible,

como hemos dicho antes,

que es sostenible, que es respetuoso

con la privacidad,

que se centra en las personas

y que es especialmente cuidadoso con

los individuos y colectivos

más desfavorecidos, porque la

idea es que otra tecnología

y tenemos que aprovechar las

oportunidades que nos ofrece

la tecnología,

pero otro enfoque de la tecnología

es si es posible.

Dicho esto, y para ir terminando,

porque tampoco quiero ver si puede

haber lugar a un diálogo,

aunque estemos así mediados

tecnológicamente por las pantallas,

quiero también señalar algunas

algunos riesgos,

algunas limitaciones también

de la ética

para nuestra convivencia, con

la inteligencia artificial,

en la robótica,

y porque hay que hacer también un

cierto ejercicio de autocrítica.

Bueno, hay una limitación interna

que es propia de la misma ética,

y es que es la dificultad

para poder considerar

los posibles impactos sociales,

ambientales o intergeneracionales

de una determinada tecnología basada

en inteligencia artificial,

porque son esos sistemas que son muy

autónomos, que son escalable,

es que cambian rápidamente

entonces el poder

calibrar las las consecuencias.

Sus impactos es especialmente

difícil y además, por otro lado,

los desacuerdos que existen

en Filosofía moral.

También se transfieren al

ámbito de la ética

en la inteligencia artificial.

Esto sería limitaciones internas.

Tenemos que recordar que,

como decía, filósofos de

la ciencia también

Silvio dieron graves.

Vivimos en un contexto de lo que

se conoce como ciencia.

Pues normal que es una ciencia

que tiene 4 características.

Tenemos gran incertidumbre

sobre los hechos;

tenemos valores en disputas.

Tenemos también, por otro lado,

situaciones de enorme emergencia,

como puede ser la crisis climática,

como ha sido la pandemia y por otro

lado, tenemos la necesidad

de tomar decisiones urgentes.

Ese es un poco el contexto

en el que nos movemos,

es el contexto de la

ciencia por normal

la parte de estas limitaciones

internas, que son propias

de la ética como disciplina,

podríamos hablar de 3 limitaciones

externas que yo quisiera mencionar.

Una es la inoperancia.

He dicho antes que hay una

enorme variedad de guías

de documentos sobre ética.

Ya se han recopilado ya creo que

más de 90, muy bien escritas

sobre muchos aspectos éticos

de la de estas tecnologías

o la agencia la autonomía la

moralidad los derechos

los valores las virtudes la

rendición de cuentas muchas cosas

y esto es interesante porque

muestra que hay.

Ahí hay una preocupación

por la dimensión ética

de la inteligencia artificial;

también genera confusión, ruido,

duplicación del debate.

La gran pregunta es cómo podemos

de alguna manera

transformar realmente a través

de una visión ética,

el desarrollo de la inteligencia

artificial en la robótica social

como operación los principios éticos,

y para eso hace falta una

cierta infraestructura.

Hacen falta instrumentos,

procedimiento personal pasar

de las musas al teatro

y sobre todo huir de una

visión de la ética,

con una especie de recetario

de principios,

de buenas intenciones,

y volver a la raíz

de lo que significa es interrogarse

y preguntar desde el principio

sobre estos sistemas, sobre

su desarrollo,

desde el mismo diseño sobre

sus sus impactos y acceso

a las preguntas que muchas veces

no se hacen preguntas

como he dicho antes sobre el

impacto medioambiental

sobre las asimetrías de poder que

supone este tipo de tecnologías,

sobre el activismo, también

de materias primas

y de mano de obra, mucha

inteligencia artificial

para entrenar.

Estos sistemas se basa en

el trabajo aislado

y en condiciones pésimas,

muchísima mano de obra, sobre todo

en países empobrecidos,

que son los que alimentan las

inteligencias artificiales.

No habría que caer en que la ética

se convierta en este este asunto

esté en este asunto inoperante.

Que es una especie de cháchara para

iniciados no, pero que no,

en la que no participan las personas

y los grupos más vulnerables

y que pueden ser más susceptibles

de daño;

impactos negativos por este tipo

de sistemas, no, bien,

porque tienen un acceso social

restringido a los mismos,

bien porque carecen de la suficiente

alfabetización

digital o por otras barreras

sociales, económicas o culturales,

que la ética corre el

riesgo de quedarse.

La inoperancia también corre otro

peligro es el del colonialismo,

no porque el diálogo ético

internacional sobre estas tecnologías

está dominado por una minoría

de países de alto nivel,

de desarrollo técnico

-científico, lo que excluye la

deliberación, otros muchos países

y agentes que luego se van a ver

afectados por este desarrollo,

en una reciente Guía para entender

la inteligencia artificial.

Desde el mundo mayoritario se señala

que la comprensión actual

de los sistemas de inteligencia

artificial,

robótica social, tiene una debilidad,

y es que las historias

futuros y opiniones

de la mayoría de las personas

del mundo se han eliminado

de la narrativa de estos sistemas,

y yo añadiría que también se

eliminado de la reflexión ética.

Son los mismos.

Cuando de mayoritario me refiero

a lo que se denomina,

pues de varias formas hubo países

en vías de desarrollo,

tercer mundo del sur global pero

que son las periferias,

que permanecen pasivas a los

problemas y desarrollos

son, como en este caso,

ostensiblemente global

y que tiene que ver con esas

preguntas que nos hacemos

el activismo de recursos naturales

en estos países

en unas condiciones muchas veces

que no son las adecuadas,

naturales y materias primas,

también la cuestión de

la mano de obra

se mezclaban los trabajadores

fantasma, etc. Por lo tanto,

la ética puede ser inoperante,

como he dicho antes,

puede pecar de neocolonialismo,

y, por último,

y lo que es más grave,

puede ser utilizada

por las grandes corporaciones

tecnológicas como coartada

para evitar las regulaciones.

Existe un discurso casi

ubicuo de la ética,

para las tecnologías destructivas,

que no estaba en el comienzo

del desarrollo tecnológico

de la inteligencia artificial

y la robótica social.

Hay un discurso que se alinea

mucho con los intereses

de las grandes corporaciones,

que han introducido importantes

cantidades de dinero

para crear putos o centros de

investigación sobre Inteligencia,

Artificial, bética entendía, siempre

con prácticas responsables

y voluntarias, frente a cualquier

tipo de regulación

y claro, esto es una manera de

blanqueamiento que queda alguna.

Lo que pretenden es no, no no entrar

en cuestiones importantes

que están relacionadas con

estas tecnologías

y que tienen que ver con la

propiedad, con el bien común,

con la legitimidad del desarrollo

de las mismas,

con un pluralismo razonable, con

cuestiones de asimetría,

de poder, etc. Por tanto,

habría que ver

que no se utilice la ética

como una coartada

para evitar la regulaciones.

En definitiva, con respecto

a la robótica social,

la inteligencia artificial,

lo que nos encontramos

es 1 de los retos más importantes

del mundo contemporáneo,

y es, como configurar esa

interacción entre el humano

y la máquina entre el humano y

estos sistemas tecnológicos

con los cuales ya estamos híbridas.

Por lo tanto, hay que considerar

además que se ha dado el salto

y que los artefactos operan en un

entorno complejo y cambiante,

donde el ser humano está situada

en el centro del diseño,

pero donde estamos constituidos

de esta manera

y en términos de una agencia

compartida.

Por ello es crucial la pregunta

sobre la ética absolutamente necesaria

y sobre cuál es el marco

de convivencia

que queremos establecer

en este contexto

de los nuevos entornos técnicos, en

los cuales los cuales vivimos,

como decía Ortega.

Muchas gracias.

Bueno, hubo muchísimas gracias a esto

y si ahora el público quiere

levantar la mano,

quiere plantear cualquier

pregunta comentario.

Pues será bienvenido.

Yo me están preguntando

si el imaginario que nos legó la

saga de La Guerra de las Galaxias

en la que aparecen robots que

interactúan con los seres humanos

está presente de alguna manera

en esa mentalidad colectiva

en la cual, pues vemos cómo

prácticamente inevitable,

e incluso maravilloso

que un simpático 3,

pero como se llamará, está

ayudando a los humanos,

a hacer determinadas tareas

y, bueno, pues a lo mejor

llega un momento en que también

nos parece normal subirnos

a un coche que no lleva conductor,

o nos parece normal

que haya un montón de cosas que las

máquinas y y que era impensable

hace unos años, que eso ocurriera,

y eso, pues llega a formar parte

de nuestra normalidad

sin ningún tipo de barreras,

como que la efectivamente, la ética

estaría llegando un poco tarde,

porque ya llegó antes.

El creador de la saga de

esa saga de Lucas

era.

Yo llegaba mucho antes que entonces.

Bueno, soy la sensación

de que todo eso ya está como

por dado por descontado.

Es decir, ya se daba por descontado

de que la robótica está aquí;

la actividad está aquí y ha

venido para quedarse

y simplemente lo que tenemos

que hacer es

intentar convivir con ella

de un modo amigable.

No sé si este comentario

parece ocioso

si no, no creo que es muy

interesante y de hecho nosotros en el grupo

hemos hecho incluso algunas algunas

pequeñas reuniones

y cine fueron precisamente

analizando el papel de la ciencia ficción

en la reflexión ética

para para robótica

y la inteligencia artificial,

porque, efectivamente,

la ciencia ficción

se ha adelantado a muchos de los

planteamientos planteamientos

podríamos decir apocalípticos ya

a planteamientos integrados.

No creo que la reflexión ética y

filosófica está precisamente

en el análisis crítico de

estas tecnologías,

no existiera apocalípticos y

hubiesen integrado sin ser utópicos,

distópico.

Pero la ciencia ficción ha sido una

herramienta muy interesante

en la sala que mencionaba,

que aparecían unos robots

relativamente amables.

En otras series o películas

que hemos visto,

aparecen otras situaciones

completamente horrorosas;

entonces yo creo que las narrativas

nos permiten también pensar

cómo queremos configurar

en el futuro,

y yo creo que precisamente

la literatura

y la son una herramienta

muy interesante

para plantear problemas éticos

relacionados con el desarrollo

de estas tecnologías.

Hay un libro que no se instala,

descatalogado;

está publicado en Tirant lo

Blanc de sobre Star Trek

y los derechos humanos, que escribió

un filósofo Derecho,

Alfonso García Figueroa que

están hubiese Castilla

donde plantea también por ejemplo

hasta qué punto 1 de los personajes

que que quiere estar en esta

saga de Star Trek

le conozco menos, pues tenía

derechos humanos o no tenía derecho

a ser un androide, no, pero que

tenía cierto grado de autonomía

la había tomado una serie

de decisiones.

De todas formas, eso también,

la ciencia ficción

nos pone en relación con con una

inteligencia artificial,

o una robótica interactiva, que

ahora mismo es eso, es ciencia

ficción los mismos expertos que

trabajan en la robótica

inteligencia artificial lo que hacen

es decir bueno nuestras nuestra

nuestra situación actual

es muchísimo más molesta, seguida

de inteligencia,

la singularidad, la inteligencia

artificial general,

que va a superar a los humanos.

Es absolutamente ahora

mismo, imposible.

Entonces, lo que tenemos

que centrarnos es

cómo nos integramos con sistemas

de tecnología que pueden

ser muy útiles para mejorar,

por ejemplo,

servicios de atención sanitaria,

servicios de cuidado y gestión

de políticas públicas, gestión

medioambiental,

pero como lo hacemos de una manera

que no sea crítica,

sino que en la cual tengamos

una participación

y no nos entreguemos sin más a

una suerte de solución mismo

tecnológico Yo creo que

ése es el puto

y el lugar que le corresponde,

precisamente la reflexión

ética y filosófica,

que luego se puede traducir en

normas jurídicas regulaciones etc

pero nosotros tenemos que

hacer las preguntas

las preguntas sobre esta tecnología

en la cual estamos y que,

de alguna manera,

pues se adelantaban en esas series

y películas de ciencia ficción,

Ahora mismo estoy hablando con todos

ustedes, todos, vosotros,

a mi abuelo, le parecería ciencia

que nos estuviéramos viendo esto.

Salían las películas también

de los años 50.

Y ahora lo hemos completamente

normal.

Nuestros hijos y nuestros nietos.

Cogen los móviles y las pantallas,

hemos dado un salto.

La pregunta importante es.

Cómo queremos que se construyan

esas tecnologías,

sí al servicio de las personas

o al servicio

de grandes corporaciones, al

servicio de otros intereses,

o con una merma de derechos y

libertades fundamentales.

No es la gran cuestión la cuestión

ya de la antropofagia antropomorfos

indización de éstos de estos sistemas

de atribuirles creatividad

inteligencia general sentimientos

eso sigue siendo y está bien

que nos lo planteamos

porque nos permite.

Creo que la imaginación es

un elemento fundamental

para la ética, la filosofía,

pero es eso, es imaginación para

pensar futuros posibles,

que no tienen que ser necesariamente

distópico,

sino que podrán ser lo que nosotros

queramos que sean.

Si intervenimos en esto

y no nos dejamos llevar también por

una suerte de inevitabilidad,

a veces no hay que introducir un

sistema de inteligencia artificial

o de robótica en un contexto, y esa

es la pregunta que yo quería.

Además, la primera buena

práctica cuando 1

habla con expertos en inteligencia

artificial,

como los colegas de inteligencia

artificial que está en Barcelona,

llegará si se plantea sistemas

de inteligencia artificial

para todo, cuando igual no

es necesario ese sistema

porque si hacemos una relación

impacto riesgos etc

pues no hay que empezar

a hacer ese sistema.

Hacer las preguntas es la

obligación que tenemos

como personas que nos dedicamos

a la filosofía.

Muchas gracias a más personas

que quieran intervenir.

Mercedes parece que quiere

intervenir adelante adelante

Mercedes buenas tardes

muchas desgracias

la verdad es que me ha interesado

extraordinariamente la conferencia.

Agradezco a quien ha organizado

el encuentro,

porque además Emilio lo sabe

porque forma parte

del proyecto de investigación.

Acaban de concedernos con cargo

a fondos en Eurovisión

un proyecto sobre plataformas

digitales para los cuidados

y escuchando me preguntaba

si ahora que me enfrento

a la necesidad del desarrollo de

la herramienta tecnológica,

porque el estudio es un

estudio jurídico

todos los aspectos concernidos

en la materia,

pero 1 de los objetivos es el

desarrollo de la plataforma

con una singularidad que ahora

no voy a comentar aquí

pero sí que me preguntaba si

metodológicamente sería

desde luego creo que

una buena praxis,

pero ya no sé si posible tener un

decálogo que nos orientará

desde el punto de vista ético en la

confección de la herramienta,

porque yo instintivamente me planteo

esto de la inevitabilidad

la accesibilidad,

la transparencia la explica

habilidad de la herramienta,

porque va dirigido a personas

con dificultades,

no necesariamente cognitivas,

pero sí físicas que entonces me

gustaría saber si podría contar.

Existe un un decálogo, una guía

bueno y es partidario del método solo

y cuadriculado.

Entonces me gustaría saber

si tengo esa herramienta

para incorporar a mi método,

porque estoy ahora mismo

elaborando la lista de necesidades

para trasladarle a la empresa

con la que voy a trabajar

la tecnología.

Pero yo misma quiero saber, a la hora

de configurar la desarrollándola

son los claves.

Si están descritas ya,

pues hay ahora mismo en los

proyectos de la inteligencia artificial.

En la Unión Europea existe ya

una especie de cheque para chequear

algunos aspectos

eso se puede, se puede descargar

porque ésta está disponible,

aunque claro, como está

ahora en discusión

la la artista sido un poco

la el reglamento europeo

sobre inteligencia artificial,

que está basado en riesgos,

hay algunos algunos equipos

que ya han desarrollado.

Yo le puedo mandar algún

algún ejemplo,

algún tipo de también

de cuestionario.

En el proyecto que hemos realizado

para la Fundación BBVA

sobre sesgos en algoritmos de triaje,

también hemos elaborado un pequeño

que es precisamente

para los desarrolladores, es decir,

para que eso solo lo puedo enviar

porque va a estar,

pero ya está publicado una

serie de preguntas

para que los propios desarrolladores

se vayan haciendo a la hora

de desarrollar el sistema y

que también se la hagan

las personas que lo van a

utilizar para decir.

Bueno, este sistema ofrece

garantías o garantías,

porque eso es muy importante también

en el ámbito de la salud

o de los cuidados.

También es muy importante que haya

ese tipo de prevención de cautela.

Por otro lado, es muy importante

que me parece

muy interesante la plataforma

digital para los cuidados.

Ha apuntado, porque una de

nuestras doctorandos

está trabajando precisamente

su tesis sobre el alcance,

las limitaciones del uso de

robótica, tecnología,

inteligencia artificial

para los cuidados.

No están haciendo su tesis sobre

sobre eso y que, por cierto,

creo que va a estar dentro estar

conectada con Murcia,

porque habrá una pequeña

sesión en el máster,

y doctorado debió derecho Diego,

pero hay herramientas todavía son

herramientas incipientes,

pero es muy importante hacer las

preguntas desde el principio,

porque luego no vale un poco Yo creo

que con la tecnología a veces ocurre

y esto es un discurso muy propio

de los de los que desarrollan

la tecnología, que ellos hacen

sistemas estupendos,

que funcionan muy bien, que son

muy operativos y demás,

y luego dicen que el problema es

cómo se usen esta vigencia

del uso.

Pero, pero vamos, la

tecnología tiene,

incorpora valores desde

su propio diseño,

es como se diseñe, ya

está determinando

cuál va a ser el resultado después

con respecto a su uso,

y por eso a la hora de diseñar

una plataforma

relacionada con los cuidados,

pues es muy importante

desde el principio contar

con la opinión

y el concurso de los futuros

usuarios y usuarias.

Creo que eso es fundamental.

Establecer algún tipo de estrategia

participativa inclusiva,

la cual se les tenga en cuenta,

porque además eso redunda

no solo en la calidad ética y

técnica de la herramienta,

sino también en su aceptación

y apropiación,

porque nosotros hemos trabajado

con empresas tecnológicas

como Tecnalia en el País Vasco,

que es una empresa que desarrolla

muchas herramientas para tecnologías

relacionadas con el cuidado soporte

en los domicilios para personas

con dificultades, etc. Y nos decían

que ellos han tenido que echar marcha

atrás algunos proyectos

muy bien diseñados,

muy bien desarrollados,

porque se les había ido la el punto

de vista de los usuarios

y puede ocurrir que 1 desarrolle

con la mejor intención

el mejor sistema y que luego

genera un rechazo,

porque no ha habido ese feedback

que era muy importante.

Esa alineación de valores y de

intereses y necesidades

entre los grupos afectados

y a quien va dirigido,

por ejemplo, la plataforma y la

herramienta que se proponen.

Entonces, eso es muy importante,

utilizar metodologías inclusivas

desde el principio del proyecto.

Existen esos cheques de

la Unión Europea

es bastante sencillo, pero

se suma serie preguntas,

cuando alguien va a iniciar un

proyecto de inteligencia artificial

que tenga algún tipo de riesgo

sobre las personas

y ahora se están desarrollando al

hilo de esta nueva reglamento,

que está en discusión y nosotros

hemos desarrollado

otro también para relacionado

con los sesgos,

en este caso era más centrado

en cuestiones de triaje,

pero que podrían aplicarse

a cualquier tecnología

relacionada con la tecnología basada

en Inteligencia Artificial,

relacionado en el ámbito de la salud.

Así que yo soy sin problema,

se lo agradezco;

a través de Emilio estamos

donde estamos.

En contacto directo.

Gracias.

Bueno, pues alguna pregunta más,

y si no, pues Eduardo tiene,

la mano levantada,

Eduardo es detenido, pero no he

tenido muchísimo problema

para poder conectar no

podía imaginar Yo

pienso que Pilar ha sido testigo,

estaba con el móvil, me iba a venir.

Ha sido Vega un cable que

tenía bajo el bueno,

tecnología; falló también

la tecnología,

falla precisamente por

ahí va mi cuestión,

y se está empezando a utilizar

la inteligencia artificial

para el diagnóstico ya hay varios

grupos de investigación

que recogen información.

Entonces La bamba aplicará

Inteligencia Artificial,

paga discrimina.

Habrá alguna manera que

proceso subsidiario

de una mayor análisis.

Se está hablando también de aplicar

y mantener determinado fenómenos

cada vehículo que esa vivienda vayan

vedadas concentraciones

de temblado marcador en

los vascos se salda.

Yo me pregunto qué opina al respecto

que evidentemente,

todo esto tiene un margen de error.

Estamos comentando.

Ante este margen de error,

puede tener importantes

repercusiones para una persona

dentro de esa sensibilidad

de la cueva.

Ya más chica quede fuera.

Fue objeto de seguimiento.

Como puede ocurrir también en

cualquier análisis bioquímico,

yo me pregunto, llega ahí.

Hemos aplicado artificial

en el ámbito judicial,

sentencias judiciales y que haya

dicho que la evaluación

de lo que has comentado de no

aplicar la Inteligencia Artificial

absolutamente para todo saben

sale de alguna manera

en limitar seriamente donde no sé la

aplicación es defensa oficial

y, por tanto la conclusión

de que podemos tener

de una aplicación indiscriminada.

Claro, no es eso.

Esa es una buena pregunta

crucial en realidad,

2 sistemas de inteligencia

artificial que su nombre muy bonito

y muy pomposo,

pero no dejan de ser sistemas de

control delegado, digamos,

no es la delegación de

algunas funciones.

Pues nosotros tenemos que

preguntarnos primero,

en qué contextos estamos dispuestos

a aceptar la delegación

y quizás podemos plantearnos que

en determinados contextos

pues no ha lugar.

Por ejemplo, en cuestiones,

por ejemplo,

de Derecho Administrativo.

Podemos aceptar que que se

se utilicen sistemas,

sistemas de este tipo porque

manejan muchos datos

y pueden dar una serie de resultados

de manera muy rápida

y agilizar los procedimientos

y y las políticas públicas y

otros en otros contextos

como la justicia penal.

Pues es mucho más restrictivos,

siempre y cuando hay que reconocer

que en esos contextos además estos

sistemas son sistemas de apoyo

a la decisión que no nos sustituyen

en ningún caso,

por ejemplo, al juez,

y en el caso del ámbito de la

salud se discute mucho,

porque porque se habla del sesgo

de la automatización,

que se ha estudiado mucho en pilotos

de avión por ejemplo,

y en médicos no, que es una

confianza excesiva

en el resultado que ofrecen las

máquinas a ver los los humanos.

Somos muy fans libres,

pero las máquinas también.

Entonces lo que hay que buscar es

determinados contextos sensibles

que haya una combinación equilibrada

y por eso explica habilidad

es importante,

porque en el caso de que ocurra

algún resultado negativo

hay que poder, podrán analizar

el proceso,

la responsabilidad, etc. Porque si

no estamos antisistemas de caja negra,

hay un caso que es muy conocido.

Ya se citan en el extranjero y

me sorprendió en Argentina.

Me encontré en un foro

como este online,

que se citaba el caso del algoritmo

Bosco, que es el que utilizaba

el Gobierno de España

para otorgar los que utilizan

utilizando para el bono social

de la energía y demás para

personas desfavorecidas

a través de una denuncia de una

persona que le fue denegada.

Ese pidió que la Administración, a

través del Consejo de Transparencia

dijera que han sido los parámetros y

los elementos que este algoritmo

maneja para gestionar esta

esta política pública,

que no deja de ser un derecho social.

El algoritmo favorece esa, facilita

mucho porque es muy rápido,

pero puede tener errores.

Si esta persona reclamaba

su derecho a saber,

lo tremendo fue la respuesta ha sido

que el algoritmo es un algoritmo

desarrollado por una compañía

privada que está protegido

por propiedad intelectual

y propiedad industrial,

con lo cual no se ha hecho explícito

cuál ha sido los parámetros

que ha utilizado.

El proceso está en curso,

todavía ha habido una sentencia

a favor del Estado,

pero hay una organización que

que exhibió que ha vuelto

a recurrir el fallo porque,

claro, realmente fíjense,

aquí hay derecho social que

está siendo que es

una cuestión de política pública y

hechos que está siendo gestionado

a través de un algoritmo que no

se puede conocer cuál es

el los elementos que lo constituyen.

No es cierto que hay algoritmos que

basados en aprendizaje profundo

cuya explica habilidad

es más difícil,

pero en cualquier caso

hay que establecer,

y quizás haya que renunciar

a ciertos grados,

podríamos decir de precisión,

algorítmica,

en aras de la aplicabilidad,

porque esa aplicabilidad

favorece primero

la legitimidad del instrumento y la

asunción de responsabilidades

en el caso, por ejemplo,

de que haya problemas,

como en este caso hay una persona

que reclamaba entonces

creo que hay que ser cuidadosos.

Hay infinidad de contextos donde

el uso de herramientas

de este tipo en el ámbito de

la medicina muchísimos,

también para el análisis

de cantidades masivas

de imágenes, por ejemplo,

para establecer correlaciones,

son muy útiles,

pero, ojo, también hay

un margen de error.

También hay posibilidad de fallos,

y lo mismo que en el ámbito humano

se asumen responsabilidades

y se reparan y se cuando

cuando al lugar,

pues tiene que ocurrir lo mismo con

el ámbito de las máquinas,

y eso además implica

que en determinados contextos igual

hay que limitar su uso,

porque son cuestiones especialmente

sensibles.

No lo pienso que el derecho penal

hay que ser especialmente cuidadoso,

que puede haber sistemas de apoyo

a la toma de decisión,

pero que en ningún caso habría que

dejar que una máquina decidiera,

por ejemplo, sobre cuestiones

de justicia penal

en Cataluña lleva funcionando creo

que lo hicieron más de 15 años,

un sistema para evaluar el

riesgo de reincidencia

de las personas que están presas,

pero es un sistema que,

por lo que han hecho una evaluación

ha funcionado bastante bien.

Tiene también algún problema.

Tiene algún problema que se ha

ido además corrigiendo,

como en los sistemas humanos también

vamos aprendiendo de los errores,

pero lo importante es que

es un sistema de apoyo

a la decisión.

La decisión sigue

siendo la Junta de Tratamiento

del centro penitenciario,

que con los datos que ofrece el

programa toma la decisión.

Pero no necesariamente tiene

que ser la misma

o exactamente la misma que la

que ofrece el sistema,

porque ahí precisamente estamos

ante una contexto

especialmente sensible.

Muchas gracias.

Pues no sé si estamos

ya fuera de tiempo

y largo, si no, no, no le digo

a Pilar que como ve,

ahí vamos.

Bueno, si alguien quiere

hacer alguna pregunta,

pues entonces vamos,

vamos despidiendo,

te agradecemos en él atendido

esta tarde

y ya sabes que tienes

aquí a tus amigos

y que vengan cuando quieras y

sabemos que vienes a menudo a Murcia

y que podamos tener esa experiencia

presencial

a la que alude a ese antes,

pues lo antes posible,

y si es posible, pues

con un buen vino,

una buena cervecita, varios

puestos, parte,

encantado un placer, gracias

por la invitación

y deseando estar en Murcia

cuanto antes, Mercedes

muy interesado por su proyecto,

y estaremos en contacto,

porque nos interesa mucho el

tema de precisamente la.

Este tipo de tecnologías

para los cuidados.

Realmente es un ámbito en el

que se está desarrollando

de una manera muy rápida, pero que

necesita precisamente quizás

un poco de sosiego para hacerse las

preguntas sobre cómo hacerlo.

Lo mejor posible, Gracias,

pensaba escribirle ahora

para ponernos en contacto

afecto bueno

hasta la próxima mucha gran

avalancha una plaza para la grabación Si

quieres para Dallas, pues nos

damos un abrazo virtual.

Por El abrazo real.

![]() o pulsar la combinación de teclas Ctrl+V.

o pulsar la combinación de teclas Ctrl+V.