Para mí estaban

punto.

Montilla.

Buenos días.

Vamos a hacer una presentación

general del proyecto Hércules

ha sido me llamo Esteban

ayer no pudimos hacer esta

presentación, que era un poco

la que da el marco general

de que esa acción

y donde se encuentra dentro

del proyecto

Hércules, que es un proyecto mayor

que engloba a varios proyectos

en los que está haciendo

y que se ocupa de varios aspectos

relacionados con la gestión

de la información de la

investigación en la universidad española.

Los temas que vamos a tratar

son, en primer lugar,

una presentación breve de la

ute que está haciendo

el proyecto que está

formada por Nóos.

La empresa a la que cogió la versión

de esto una descripción del proyecto

Hércules en conjunto, una

presentación del proyecto

Hércules ha sido aquí haremos

un inciso para hablar

de lo que son datos abiertos

y enlazados

y los brazos de conocimiento,

que son 2.

Tecnologías habilitadas

para el proyecto

y tecnologías fundamentales,

para el proyecto son, son una guía

de qué es lo que se quiere,

construir y explican muchos

porqués y muchos cómodos;

y finalmente las dos partes

de las que se compone,

así por una parte, la

infraestructura antológica,

que es la y la moderación,

y por otra parte,

la arquitectura semántica.

Qué es la?

El conjunto de modelos y

sistemas que al final

dan soporte y expresión

a estos datos,

hacia los usuarios.

No es una pyme que lleva en,

lleva haciendo desarrollos

tecnológicos

en la construcción de rasgos

de conocimiento,

de la voz de los datos, es lo que

se llama la web semántica

desde hace más de 10 años

nuestra ideas,

hacer una transformación en las

empresas de inteligencia humana,

en inteligencia tecnológico,

artificial, con modestia sabemos

a nosotros cómo vamos a comentar.

Luego tenemos una idea de que

la la, la tecnología tiene

que saber, tiene que servir

a las personas

y la inteligencia artificial

aún tiene muchos límites.

El objetivo es facilitar

a las personas

el acceso a una vida digital

o más es lo que hacemos.

No estamos en transformación digital,

creemos que es un concepto

un poco gastado.

Nosotros lo que queremos es poner

la tecnología en su sitio,

es una tecnología que está

fabricada en España,

pensamos que desde España

se puede competir

y de hecho se debe competir con

empresas que en realidad

vienen desde fuera y no estarán

nuestros servicios,

sino más bien al revés, hacemos

Inteligencia Artificial

en español y nuestros desarrollo se

basan en que todo está enlazado,

hacemos Inteligencia, Artificial,

se usando gafas de conocimiento.

es nuestra visión tecnológica.

Pensamos que la tecnología no es

neutral, no, no es lo mismo

hacer las cosas de una

manera que de otra.

Usando las tecnologías de la

web semántica pensamos

que se acerca más los los resultados

se acerca más

a una experiencia humana y es

una experiencia digital,

mejor algunos de nuestros clientes

en lo que serían Cultura,

Administración Pública, Educación

y Universidad,

banca y cuando no empresa privada.

En cuanto al texto de esto,

es una universidad bastante conocida,

es una universidad privada.

Está fundada en 1.886 con

estas seis facultades

que veis aquí y nosotros

en particular,

estamos colaborando en esta ute con

con el grupo de investigación

de esto, que, como veis,

tienen un lema.

Están en un ámbito bastante

parecido al nuestro, de.

Digamos, la tecnología aplicada

a las personas

y buscar inteligencias

vidas, es decir,

una colaboración entre

personas y máquinas.

Estas son las áreas de conocimiento

en las que trabajaban,

monedas que están muy conectadas

con este proyecto,

en particular las que tienen que

ver con la web semántica,

pero no solo porque también el punto

de vista que tienen respecto al uso

de los datos en unas pruebas que

beneficie a la sociedad

en su conjunto es muy importante

algunos de los de los proyectos

que han hecho que tienen relación

con este proyecto,

pues conocían relación como veis

con con con ciudadanía

con tecnología semántica con

interoperabilidad contactos etc

el proyecto del Hércules entrando

ya un poco en detalle

de nuestro proyecto, el

por qué estamos aquí;

es un proyecto de de datos

de investigación,

universidades, lo que busca es

crear un sistema de gestión

de investigación, un que esté

basado en datos abiertos,

que ofrezca una visión global de

los datos de investigación

del sistema universitario español,

el objetivo o los objetivos,

cuales son mejorar la gestión,

el análisis y generar sinergias

entre universidades y el gran público.

Los dos pilares que tienen los

culés fundamentales son,

por una parte, la arquitectura

semántica.

Por otra parte, el prototipo

innovador

de un sistema de gestión

de la investigación.

Este es el proyecto Hércules sg

-que está construyendo otro equipo

en el que también participamos.

Nosotros qué es el sistema base,

digamos, de de gestión?

La información de la investigación.

El proyecto tiene tres proyectos.

Por una parte, el proyecto

Hércules Paz

tiene tres sus proyectos.

Por una parte, esta acción,

que tiene dos partes, 1.

En primer lugar estaría

arquitectura de datos

del sistema universitario español.

Por otra parte, la infraestructura

antológica

de la información del sistema

universal espacio

-ley es el sistema de gestión

de la investigación,

y esta enzima, que son el último

proyecto que se divide en 2,

por una parte estaría el

enriquecimiento de datos

de la investigación a partir

de fuentes externas

de internet, y por otra

parte el análisis.

Se mantiene los métodos de

análisis semántico,

ya que que permitió una serie

de explotaciones avanzadas

y comparativas de los resultados

de los datos,

de la investigación entre

universidades grupos

de investigación investigadores

proyectos etc.

Un poco más en detalle ha

sido lo que hace es

desarrollar una plataforma eficiente

de hacinamiento,

gestión y publicación de los datos;

usará una infraestructura antológica

y tendrá la capacidad de sincronizar

instancias instaladas

en diferentes universidades una

parte y la otra es que vamos a crear

una red de antologías un

modelo antológico

que se va a poder usar para

describir de manera fiel

y con gran claridad los datos de la

gestión de la investigación.

Les dije que el sistema de gestión

de la investigación

es un prototipo innovador,

con sistema de gestión integral

de la investigación,

que potencialmente puede ser

integrado en cualquier universidad.

Incluye todas las actividades de

gestión que estén relacionadas

con la investigación

y estará integrado, va

a estar enterrado;

con la arquitectura se desarrollada

opcionalmente.

Esto no es obligatorio,

opcionalmente podrá estar y lo

que hace es identificar,

extraer y analizar y evaluar datos

relevantes que ha completado,

a partir de la información de

fuentes externas de información un poco

en el detalle de la comunicación

entre estos proyectos

está representado.

En este esquema tenemos

que les envía datos.

Así ha sido consolidar datos

en una central única.

Estos datos se modela con

tecnologías de la web semántica

como veremos.

Luego, tanto nació como encima

explota los datos del nodo central

y enriquece los datos de

fuentes de internet

y, encima, se conecta con

ese para la gestión

de proyectos currículo y para

comunicar los datos,

enriquecido.

Que es el proyecto por el

que estamos hoy aquí

así como ya hemos dicho antes,

corresponde a las siglas.

Son así las que corresponden

a arquitectura,

se mantenga la infraestructura

antológica.

El proyecto busca construir y

explotar un brazo de conocimiento

que, como todo buen grado

de conocimiento,

tiene que ser unificado.

Interrogarle extensible

y y expresivo.

Este grapo de conocimiento

recoge datos

de la investigación universitaria

del sistema universitario español.

La parte de infraestructura

antológica lo que hace

es crear una red de antologías que

se que se puede usar para,

como ya hemos dicho antes, para

describir fiel de una forma fiel

y con regularidad.

Los datos del dominio

en cuanto a la arquitectura

semántica, que es la otra,

la otra pieza del de Hércules ha

sido, es un vaquero del sentido

de que es un respaldo,

de alguna manera,

de los datos de entonces, una

plataforma eficiente

que almacena, gestiona y publica

los datos de sgae

basándose en la infraestructura

antológica,

con una capacidad para sincronizar

instancias instaladas

en diferentes universidades y

permitir explotaciones inteligentes

de la información de investigación

de la universidad

y el sistema universitario

en conjunto.

La arquitectura de acción

corresponde a este esquema general,

en el que tenemos un nodo unidad,

hay varias universidades conectadas

y tienen unas características

que pueden resumir en estas 5.

Cada nodo tiene cuatro módulos.

Existir una carga, una

consulta pública

y privada.

Los malos ha sido, consolidan

datos en el nodo,

unidad, datos homogéneos, entrenados.

Cada nueva base cuenta con un

de conocimiento completo

de sus entidades, del dominio,

de gestión de investigación,

y el nodo central cubierta contaría

con un mejor conocimiento

de la globalidad del potencialmente

según se fueron incorporando

universidades que recibe

de cada nuevo.

Así.

Tal y como está planteado,

el proyecto ha sido la base de

Osuna o es una de las bases

para la construcción de un

sistema inteligente

del sistema de investigación de

la universidad española,

es decir, va a permitir gracias a

las tecnologías estos marcos tecnológicos

en los que está desarrollado

explotaciones inteligentes

avanzadas de la información

de la investigación.

El marco tecnológico

sería el programa de inteligencia

artificial

e interpretada, semánticamente,

y la explotación por parte

de humanos y máquinas

de las posibilidades que ofrece

el enlazado de datos de eta

y en un brazo de conocimiento noble.

Aquí pongo las siglas, las bolas,

los términos en inglés perdón

porque son los que podéis encontrar

de una manera más habitual

en la documentación técnica

y científica,

más que en castellano porque,

como sabéis,

la informática está muy colonizada

en sus términos;

la infraestructura antológica

lo que hace es definir

el modelo antológico que llamamos

la red de antologías Hércules

y la arquitectura,

lo que cese el desarrollo,

implementación de componentes,

que posibilita la carrera

interrogación de este grapo

de conocimiento, modelado

con las antologías

Hércules.

Aquí vamos a hacer un inciso momento

para explicar, aunque bueno,

digo de un vistazo ayer

explicar un poco,

pero que son los datos enlazados

y abiertos,

porque son importantes

para el proyecto

y que son y que es un caso

de conocimiento.

En cuanto al primer término,

los datos enlazados

y abiertos.

Vamos a empezar por definir

que son datos abiertos;

los datos abiertos son

aquellos que pueden

ser utilizados; reutilizados

y redistribuir

por cualquier persona de manera libre

y que se encuentran sujetos

como mucho,

a un requerimiento de atribución

de compartirse;

de la misma forma en la

que se en la que

se han obtenido, digamos-

a los pueden utilizar para hacer

-consideran dato abierto,

lo lo lo más que puedes expedir al

que lo que lo va a utilizar

es que diga desde dónde-ha

sacado el dato

-y que lo comparta su vez.

Puedes obligar-digamos

-por el uso -por la licencia de uso;

esto es una definición que podéis

encontrar en el Open Data.

Resumido esta definición digamos

que tiene 3, tres partes.

La información tiene que estar

disponible y accesible,

preferiblemente a través de internet,

que es lo que permite que sea que

se haga un coste razonable,

tiene que ser reutilizable,

y redistribuir incluso

que estos datos, que vosotros ponéis

porque así va a exponerse,

puedan integrar en otros conjuntos

y tiene que permitir

una participación universal,

es decir,

todos tienen que poder utilizar,

reutilizar y redistribuir,

sino una discriminación

por restricciones

que no sean no comerciales, es decir,

porque si a ti no, esto no

sirve para ser un tacto

abierto en datos abiertos abierto

para todo el mundo entonces bueno

la la la clave de la de la exigencia

es que todos estos,

tras esas características

anteriores, lo que lo que posibilitan

es que los datos sean interoperable,

entonces interoperable,

que es que que sería una habilidad

de la interoperabilidad

es la habilidad para interpelar

a integrar

diferentes conjuntos de datos,

permitiendo que componentes distintos

den un resultado común conjunta.

Esto puede ser, los podemos

mezclar unos datos

abiertos con otros y esto puede

da unos beneficios.

Nos benefició beneficios prácticos

de explotación.

Que, que para todos aquellos que

permitan combinar datos

y generar una información nueva,

mejores productos y servicios.

Respecto a los datos abiertos,

el movimiento en general,

lo que lo que recomienda

es que los datos estén expuestos

cuanto antes,

sin preocuparte mucho por

por cuál es el formato

en el que lo hace.

Entonces, en este sentido, datos

abiertos pueden ser.

Todas estas cosas, pueden ser

un fichero de oeste,

aunque sea propietario.

Puede ser un dato abierto, puede ser

que tiene ciertas limitaciones,

pues contextos y demás.

Puede ser una piña pueden

ser margaritas,

datos con información

acerca de los datos

o pueden ser sorprendente.

Es decir, datos abiertos y enlazados,

y además en la tabla con otros datos.

Sucede, pues que no todos los datos

abiertos son exactamente iguales.

No es lo mismo de hacer las cosas

de una forma que de otra.

Entonces sí sí sí nos vamos

a esta fase anterior

que la rapidez es un factor

de innovación,

y por eso es por lo que se promueve

que los datos se abran cuanto antes.

Es cierto que es que los datos sean

incómodos de usar es un problema

y un freno para esa innovación.

Entonces, posibles problemas

puede tener la gente,

reutilizar, datos abiertos, que

sean una descarga de ficheros

o no sea el tema.

Hay temas con la obtención de temas.

Con el modelo.

Si es cerrado,

es abierto, es público o privado,

etc. La relación entre los datos,

es decir, se puede acceder

tabla, tabla,

o puedes combinar unas

tablas o unos datos.

Con otros están lanzado con

otros datos exactos.

La actualización se hace

mediante descarga.

Hay una pie de quienes

responsabilidad,

de actualizar esos datos

del del propietario,

y por último, cómo se difunden

estos datos.

Entonces, en lo que respecta, a sido

si alguien quiere reutilizar

los datos de acción con

la arquitectura,

se mantiene esa construido.

Va a disponer de una

app para hacerlo.

Los datos van a hacer.

Bueno, el modelo con

el que está hecho

es abierto, va a ser público,

responde a estándares expresivo

y extensible.

Es una antología basada en está

basada en estándares

de la web semántica.

Permite acceso a las relaciones

entre los datos

porque permite ejecutar consultas

mediante sea pie,

con lo cual no solamente accedes a

una tabla una vista concreta,

sino que accede al conjunto

de los datos,

y puedes hacer las relaciones

que quieras

o que el sistema permite;

los datos van a estar en la

zaga con fuentes externas

y se pueden enlazar con

fuentes externas;

la actualización se hace mediante

si alguien quiere actualizar

unos datos que están utilizando para

tener una app, para hacerlo,

y la responsabilidad de que los

datos estén actualizados

es el propietario, no es reutilizado.

Los datos siempre están actualizados

y, por último, la difusión

de los datos,

que en este caso es web y es activa,

es decir, los datos se comunican

hacia fuera continuamente,

al final que pasa es que

el es el mejor medio

para publicar datos abiertos

hoy en día;

entonces, es por esto por lo que

es una de las tecnologías,

uno de los marcos tecnológicos

fundamentales del proyecto.

El segundo que queríamos comentar

hoy era el de los gastos

de conocimiento.

Entonces qué es un grifo

de conocimiento?

Yo lo voy a intentar explicar

de una manera visual.

Vale, vamos a suponer

que estas 16 personas son

16 investigadores

que están asistiendo a un zumo

similar, muy contentos,

la mayor parte de ellos entonces,

cada uno de ellos,

cada una de estas personas

es una entidad,

es una entidad de manera general.

Tenemos, por otra parte,

otra entidad,

que puede ser un una publicación

de investigación,

por ejemplo, esta biomarcadores del

Trastorno del Espectro Autista

basados en dio señales en directo,

la inteligencia artificial su

pay per que, según vemos,

pues parece que tiene que puede

tener relación con tres temas que son

neurobiología, genética,

inteligencia, artificial.

Cada uno de esos temas es

a su vez una entidad,

son entidades una entidad

que es un concepto,

pero es una entidad.

Entonces tenemos ya una

relación aquí;

es decir, este esta publicación

tiene una relación

con esos tres temas.

Por otra parte, la publicación

tiene tres autores,

es decir, tenemos una entidad,

la publicación,

relacionada con los tres autores

que han generado.

Esa publicación,

esto, de una manera implícita

no explícita,

establece una relación entre

estas tres personas.

Es decir, las tres personas

se relacionan.

Tienen una relación porque colaboran

en una publicación.

También podemos tener a personas

que tienen relación

con otras entidades que con de

en qué áreas de conocimiento

tienen experiencia o conocimiento.

Por ejemplo, tenemos tres personas

que tienen experiencia.

Conocimiento en Inteligencia

Artificial,

acuerdo?

Esto también genera un brazo de

conocimiento implícito entre ellas.

Es decir, esta serían tres personas

que están relacionadas

porque comparten un ámbito

de conocimiento,

un área de conocimiento.

Aquí tenemos una persona que tiene

unas características alguien común,

es decir, es una persona que trabaja

en Inteligencia Artificial

y que ha trabajado en

ese o ha producido

esa publicación científica.

Entonces, qué es lo que permite

el grifo de conocimiento,

razones de conocimiento, lo que

permite hacer relaciones,

es decir, bueno, hacer o contestar.

Preguntas del tipo de que

investigadora investigadora

ha trabajado en proyectos

de Neurobiología

y es experta en el área de

Inteligencia Artificial,

entonces tenemos esta persona,

tenemos un documento que está

relacionado con neurobiología

y tenemos una relación de autoría

del documento hace esta persona.

Por tanto,

la persona que nos interesaría

en este caso

sería entonces esto visualmente,

un un corazón de conocimiento

no es más que el conjunto

de entidades

y sus relaciones de un ámbito

de conocimiento concreto.

Esto, evidentemente, puede ser

representar visualmente el grifo

de conocimiento de los

investigadores de la Universidad,

luego veremos un ejemplo reducido

en un único investigador,

pero representarlo visualmente

es prácticamente imposible,

quedaría una malla que, que

nadie podría haber,

pero realmente es una malla

gigante de relaciones

entre muchísimas entidades,

todas ellas dentro del ámbito de la

gestión de la investigación.

Entonces, qué que expresa como

expresa el grado de conocimiento

de estas relaciones?

Pues esto está expresado

en frases simples

que son perjudicados de primer

orden con frases

como ésta Laura es autora de la

publicación biomarcadores

que veíamos antes genéticas.

En era conocimiento de la publicación

Neurobiología sonora de conocimiento

de la pública,

de la publicación, inteligencia

artificial.

Es otro área de conocimiento

de la investiga,

investigan el área de conocimiento,

inteligencia artificial Akira,

que es otra es otra de las personas

que teníamos ahí antes es autor

de la publicación biomarcadores

quiere investigar

el reconocimiento genética

y, como decía antes,

extraer conclusiones como estas no

las personas que investigan

en el área de conocimiento de

la inteligencia artificial,

que han participado en

investigaciones

de la reconocimiento de genética.

Son Laura y otras un afán de

conocimiento al final.

Finalmente, está construido por

un conjunto bastante grande

de The de frases simples

de este estilo,

es decir, digamos que la

antología lo que hace

es que define el modelo antológico.

Define la frase es persona, es autor

o autora de publicación.

Esa es la frase que está definida

la antología y la frase

y las frases que están cargadas

en el grado de conocimiento.

Son todas estas que son

frases cargadas,

que responden a ese modelo.

De la manera más formal,

un brazo de conocimiento es

una forma de integrar

y representar información

heterogénea y distribuida,

y que permite descubrir a investigar

cualquier tema

de una manera más más intuitiva,

es decir,

el tipo de preguntas que

permite hacer son más,

digamos que responden menos obvias.

La hermana y a la reunión disculpa

germano está con nosotros.

Si alguien quiere excluir a Sánchez,

no le vale saber Aquí

la Tierra Media,

cuando observan puesto que Germán,

puedes voy a desactivar la rodea.

Disculpas, él decía que a

el tipo de consultas,

que permite de interrogaciones,

que permite tienen más que ver con

el ámbito de conocimiento

y con el modelo que con decisiones

que se han tomado

sobre qué se puede consultar desde

un sistema informático,

es decir, en principio, un

un sistema informático

desarrollado sobre un brazo

de conocimiento va

a permitir cualquier tipo de

consulta que tenga sentido

en ese ámbito de conocimiento,

incluso consultas que

no son explícitas,

sino que son implícitas como

esta, que hemos visto,

que era muy sencilla,

se puede formular con lenguajes

de consulta

y con interfaces construidos

para explotarlos al final,

lo que permiten los brazos?

De conocimiento

es dotar de sentido común a los

sistemas informáticos,

de manera que pueden desarrollar

la inteligencia contextual

en un dominio amplio de conocimiento

como el que tenemos aquí,

por ejemplo, es el de la gestión

de la investigación bueno,

por por por colocar el asunto

un poco en el sitio

desde un punto de vista

más comercial,

que no sea algo que decimos nosotros,

aparte de que los datos de

conocimiento están siendo usados,

como ya comentó Diego por

grandes empresas

como Google, Facebook y otras.

Digamos que empresas que analizan

o que se dedican a analizar las

tendencias desde el punto

de vista tecnológico y económico

se sitúan a los campos

de conocimiento ahora mismo en

un punto muy importante,

y piensan que es bueno, que es uno

de los de las tecnologías clave

para para explotar la información.

En este mundo crecientemente

complejo que tenemos,

vamos a entrar ya en la parte de Asia

en describir lo que sería la

infraestructura antológica.

La infraestructura antológica

fundamentalmente lo que hace

es definir el modelo antológico

del brazo de conocimiento

de la investigación universitaria,

es decir,

en ese ejemplo os he puesto antes el

conjunto de frases que explicarían

cómo se modela la gestión

de la investigación.

Es todo este tipo de frases

como persona

es autor o autora del documento.

Persona trabaja en un grupo

de investigación.

Grupo de investigación.

Gestiona este proyecto.

Ese tipo de frases son

las que se definen

en el modelo antológico.

Con un lenguaje formal,

no son frases en prosa como

las las que he hecho yo,

pero, pero básicamente lo que define

son frases de ese estilo.

Al final, de lo que se trata

es de crear una red de antologías

que es bueno,

pues, como hemos dicho ya varias

veces que pueda describir

con fidelidad y claridad.

Los datos del dominio de gestión

de la investigación.

Qué requisitos tenía que cumplir

la red de antologías Hércules?

Bueno, por una parte,

tenía que ser capaz de dar

satisfacción a los escenarios

en los que tiene que actuar, que es

el mapa del conocimiento nacional.

Cuadros de mando flexibles,

búsqueda de socios,

selección de grupos de investigación,

etc. Tiene que ser capaz de

dar soporte a este tipo

de de consultas interrogaciones

o al tipo de consultas

interrogaciones que se necesitan

para obtener estos resultados,

pero, por otra parte, están las

funcionalidades que tiene?

No debería tener ese

sea lo que puede gestionar una sgae

y que son proyectos convocatorias

y ayudas producción

científica currículum contratos

y patentes etc

se tiene que ser capaz de modelar

unas entidades que están analizadas

aquí como las autonomías atributos a

las economías o clasificaciones

de las entidades, sus sus atributos,

sus relaciones, las fuentes de datos

de cada entidad identificada puede

ser investigado, proyecto,

fuente de financiación.

Tiene unos requisitos no funcionales.

Entre los que están los principios

de pentrita que hemos

que hemos visto antes,

principio es Fer,

que veremos un poco más en detalle,

que tenga Auris persistentes;

las uvi son los identificadores

de cada entidad que sean

que que permitan que

aseguren digamos,

que incluso con el tiempo

incluso desapareció.

El sistema, de alguna manera Lauri,

puede ser resuelta y

se puede obtener,

por lo menos los metadatos

de la entidad tiene

que ser multilingüe interoperable

con otras antologías

que permitirá integrar fuentes de

información existentes externas

en las alfombras o de conocimiento

externos,

y tiene que poder ser mantenerle y

tiene que tener una licencia.

En cuanto a los principios

seguidos en el diseño

esto es un resumen breve creo

que nos lo explicó

Diego ayer esto tenía que haber ido

un poco antes de Diego, pero bueno,

tenemos el tema de la reutilización,

modelar conceptos que existen,

se ha extendido con aquellos

conceptos nuevos

identificados en el análisis

como propios

de la universidad española y

se prepara una antología

que su sable, los atributos

relaciones y restricciones.

Están documentadas para facilitar

la reutilización por parte

de los desarrolladores

fundamentalmente,

aunque pone usuarios.

Creemos que el tipo de usuarios

que utiliza una antología

básicamente es un desarrollado.

Bueno, este es el esquema general de

la infraestructura antológica

que ayer explicó Diego.

En detalle.

Aquí tenemos, tenemos reflejadas,

las entidades principales

y sus relaciones

el proyecto áreas de conocimiento

organizaciones

personas producción científica etc.

Como hemos dicho, el desarrollo

de la red de antologías

-Hércules y se sustenta en unos

principios de diseño,

que son los que hemos

comentado antes,

y luego en una documentación

de tipo descriptivo,

documentación para y documentación

formal de publicación de antologías.

Luego, un asunto importante que

tenemos unas preguntas

de competencia que es un

conjunto de consultas

se puede entender que

permiten verificar,

por una parte, que la antología,

el modelo antológico puede responder

a las a los requisitos previos de uso

y, por otra parte, permite comprobar

que la antología sigue funcionando.

Si se cambia algo la antología.

Vamos a hablar un montón

de los principios,

que es uno de los de los

factores que querían.

El el diseño de ha sido

particularmente

en infraestructura antológica

corresponde a las islas, son solo,

son unas siglas y corresponden

a fin de al.

Es decir,

que sean encontrarles que

sean accesibles,

que sean interoperable.

Sí que se puedan reutilizar.

Lo bueno es un poco juego

de palabras,

porque también en inglés

significa justo.

Bueno así que ser de eta

aparte de esto digamos

que serían datos datos buenos hay

un hay una vía que marca

estos principios que ésta

tiene esta publicación.

Básicamente, los principios

lo que hacen

es proporcionar directrices para

publicar recursos digitales,

entre los que están conjuntos

de datos, códigos,

flujos de trabajo, objeto

de investigación, etc.

Estos principios se refieren

a tres tipos de entidades:

son datos cualquier objeto

digital meta datos.

La información solo digital

y también la infraestructura.

Todo ello tiene que ser 0.

Al final limpieza es el mejor medio

para ser igual, que es el mejor medio

para publicar datos abiertos es el

mejor medio para publicarse.

Vamos a ver con detalle los pecios.

Fehr es decir que se ha

encontrado, es decir,

los metadatos y los datos deben ser

fáciles de encontrar tanto

para las personas como para

los ordenadores.

Entonces, los metadatos tienen que

ser legibles por máquinas,

de manera que permita el

descubrimiento automático de datos

o de información y servicios,

y digo y él.

Los principios que tienen que

ver con ser encontrado

son que los letrados sostienen

un científica global único

y persistente los datos?

Se describen con metadatos ricos.

Los metadatos incluyen

explícitamente el identificador de los datos

que describen los metadatos.

Se ha registrado un examen en

un recurso de búsqueda.

Qué hace?

Le sorprenda?

Tal respecto que tomen nota,

proporciona un identificador

único global y único.

Proporciona unos metadatos

descriptivos,

proporcionar un identificador y

proporciona un medio para registrar

e indexar.

El siguiente principios,

ser accesible,

decir una vez que el usuario

encuentra los datos,

tienen que poder acceder a sus datos

tal vez con autenticación,

con con una verificación, pero tiene

que poder acceder a nosotros

entonces aquí tenemos esto.

El este principio se divide en estos,

que aquí los metadatos

son recuperables

mediante su identificador

con un protocolo honor

que sean habitual y normalizado.

El protocolo tiene que ser abierto,

gratuito y de aplicación universal,

y el protocolo tiene que permitir un

procedimiento de autenticación,

si es necesario, y lo más importante,

que los metadatos son accesibles,

incluso cuando los datos ya

no están disponibles,

esto lo proporciona.

También le sorprende eta da acceso a

los datos mediante un protocolo

abierto que es.

Http.

1, es un identificador

que está expresado

como una web.

Al final tiene por una parte

del protocolo http.

O https el dominio y luego

una serie de, de partes,

de la uvi que definen o pueden

definir de qué trata la entidad,

luego veremos, algunas proporciona

persistencia.

El tercer principio es interoperable.

Los datos tienen que poder

integrarse con otros datos a con bueno.

Aplicaciones, flujos de trabajo,

cosas que permitan sistemas

que permitan el análisis,

almacenamiento y procesamiento

de estos datos.

Para ello los los de este

principio se divide en.

3.

Los metadatos tienen que utilizar

un lenguaje formal, accesible

y compartido,

y que sea reconocido y aplicable a

cualquier las representaciones

de conocimiento.

Tienen que utilizar vocabulario

es que siga los principios

y tienen que incluir algún

tipo de referencia

cualificada a otros datos.

Al final, otra vez con

la que hizo Pennetta

lo que hacemos es representar

los datos de antologías

con un lenguaje formal, accesible,

compartido y aplicable;

reutiliza propone vocabulario

es estándar

abierto y accesibles y permite

enlazar con otras.

Por último, la rusa habilidad.

Lo que busca es optimizar la

reutilización de los datos,

es decir, tienen que estar

bien descritos

para que puedan ser aplicados

y combinados.

En este sentido, tenemos

que los metadatos

tienen que describir con

una pluralidad.

Con una edad de atributos,

precisos y relevantes.

Es los metadatos se liberan

con una licencia de uso,

datos clara y accesible,

y los metadatos están asociados

a una procedencia detallada.

Además, tiene que cumplir con los

estándares de una comunidad

que sea relevante.

En ese dominio,

entonces ha sido utiliza un

vocabulario fijos y descriptivos

para.

Caracterizar las entidades del

ámbito de la gestión de la investigación.

Estos datos incluyen licencia

y procedencia,

están adaptados al dominio,

que es el que nos ocupa.

Con esto acabamos la la introducción

de lo que sería la parte

de infraestructura antológica

y vamos a pasar a la arquitecturas

la arquitectura.

Se mantiene el conjunto de

componentes y módulos

que hacen posible que estos datos,

que están modelados

con la red de antologías, con la

infraestructura antológica,

se puedan expresar, se pueden cargar

y se puedan expresar hacia fuera.

Es la arquitectura de aseo,

se caracteriza por los puestos

cinco puestos,

cinco puntos.

Cada uno tiene cuatro módulos;

los nodos se consolidan datos

en la nueva unidad,

tan datos homogéneos, entrenados

cada nueva base,

cuenta con un conocimiento completo

y el nodo central cuenta

con numerosos conocimiento

de la globalidad

del potencialmente según se fueron

incorporando universidades.

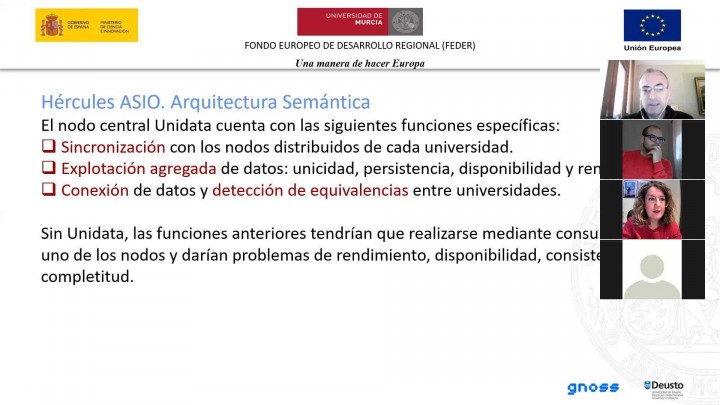

El nuevo central.

Unidad a éste tiene vamos a citarlo.

En primer lugar,

tiene unas características unas

funciones específicas.

Sincroniza con los datos

distribuidos de cada universidad; sincronizada,

datos permite la explotación

agregada de los datos de la Unicidad

y la persistencia de esta

disponibilidad,

cifras de rendimiento y permite

la conexión de datos

y detección de equivalencias

entre universidades,

es decir, si una persona ha

publicado un documento,

la Universidad de Cantabria y

también la de Murcia en unidad

a esa persona es la misma.

No son dos personas.

Todas estas funciones sin unidad

se podrían realizar,

pero necesitaría poder establecer

una especie de red de consulta

entre nudos que acabaría dando

casi con seguridad,

daría seguramente problemas de

rendimiento, disponibilidad,

consistencia y competitividad,

es decir,

si alguien quisiera consultar los

datos de cuatro universidades,

de alguna manera tendrá que

garantizar que garantizase

que siempre esas universidades

tienen sus sistemas disponibles

y el que consulta nunca

tendría la certeza

de que los datos son completos

porque algo ha podido fallar

en algún sistema.

Si se cuenta entonces para eso es

para lo que es lo que consideramos

fundamental.

Que exista un nuevo data.

Este prototipo inicial va a estar

en la Universidad de Murcia;

también la arquitectura de

componentes un poco más

explotando un poco esa arquitectura

que hemos visto

antes.

En componentes más finos digamos

tenemos una web pública.

Voy a comenzar por la parte,

por la carga;

tenemos una carga que permite

incorporar fuentes

de datos heterogéneos.

Definir las fuentes de datos, datos

y tenemos la factoría de,

que es el que permite generar

esos identificadores únicos

para cada entidad perdone que

moleste y siempre interrumpe

cuando se hacen esa entrada adelantó

en la factoría de Hury,

en la que da el identificador,

lo crea,

el mimo o nos da, digamos que

devuelve el identificador en función

de la entidad sea el identificador,

vamos a suponer que estás cargando

mediante un que sería un proyecto

que vuestra universidad

tiene el código 1.000.

Entonces, lo que hace la factoría de

Ulises asignado, un uri basándose

en qué tipo de entidad es y en

un dato que la identifica

pero que la identifican el.

La, la fuente, digamos.

Lo que pasa es que una vez que pasa

por la factoría de Ulises

identificadores, único

y universal, o sea,

no hay otra.

En el mundo que sea como esa, Bale,

pero que la la orina la hace,

la parte de los datos que de sí

sí la verdad es que saudí,

veremos luego un ejemplo extremo.

Voy, voy a saltar un poco un paso

a ver si vemos una vale

para que os hagáis idea de

lo que es una una hora

y sexto es está el protocolo.

Http.

Está el dominio y luego hay una

serie de de de partes de segmentos

en este que identifica qué

tipo de entidades

y este investigador que viene

aquí entonces llaves.

Sería el dato que vendría desde

la carga, no, pero sí mi duda

era si esa esa y se introduce cuando

se hace la carga de dato

o era la propia Vila, que con los

datos que que le llegan,

la que fue la favorita,

digamos, que se hace,

es si el Gobierno creo que

esto es un proceso.

En realidad continúa.

Digamos que los que los datos llegan.

Esos datos tienen que transformarse

de ese formato

en el que llegan, que es que

se y llegan en ese formato

y se tienen que transformar en otro.

Entonces, en el proceso

de transformación,

en el propio proceso de

transformación el necesita

que cada entidad esté definida con

un cuchillo y en ese momento

es el proceso de transformación en

el que llama a la factoría de gris

para decirle.

Oye, cuál es el Uri para

este tipo de entidad

se lo devuelven y con esa información

ya compone el dato en ese momento

cuando le da el identificador único,

esa edad?

Eso es?

Eso es a esa entidad?

Ya ya tiene charlas las cuando sí

si esa entidad viene mañana

con una actualización.

El dato está cargado ya, el

identificador existe,

no hace falta que se cree otra vez.

Esto es solamente en la primera vez

que se crea una entidad que se crea

la entidad para siempre el

investigador a partir de ahí

el proyecto.

La publicación dentro de ha sido

para tener un identificador

que va a ser único y más universal,

porque como el dominio de este

pertenece a cada universidad,

la fuente punto es.

Nadie puede tener un a

ver, yo podía tener

un que inventarme lo que tenerlo

en un sistema mío propio,

pero no tiene ningún sentido.

Porque el dominio que resuelve este

este pertenece a la universidad

y, por tanto, es una hype y una

máquina de la universidad

la que va a resolver esto.

Entonces, por eso es

por lo que se dice

que un identificador de

estos es universal,

porque lleva siempre el dominio

que el dominio es único,

tiene un propietario.

Gracias.

Vuelvo a 500.

Bueno, tenemos esta parte de lo

que sería la carga que tiene.

La sincronización con

el nuevo central

hay un sistema de programación

de cargas,

es decir, una especie de

a por decirlo así;

en pocas palabras, es como un crono,

digamos, que es el que define cada

cuánto tiempo se tienen que

actualizar estos datos.

Es decir, el sistema,

digamos que es, esa ha sido el

que pregunta a los sistemas,

fuentes por datos actualizados.

Si tienes algo nuevo,

entonces, eso no.

Lo normal es que no lo diga.

Esto veremos el haga.

En las jornadas de de

jueves y viernes,

lo normal es que esto se programe,

pues una vez al día

o dos veces al día, si no, no

es un proceso continuo,

porque tampoco se necesita

que ha sido actualizado.

El día tres bueno, porque además

ha sido hasta algunas

algunos procesos que son un

poco pesados que veremos.

Entonces.

Esto tiene una programación que

se puede que se gestiona.

Aquí después tenemos el gestor que

vamos a ver hoy a continuación,

que es que es donde se almacenan

los triples estas sentencias,

que que sustancial en datos

el brazo de conocimiento

con el módulo antológico tenemos

una web privada

donde tenemos la gestión

de la documentación,

gestión de los datáfonos

y de usuarios,

tenemos una base de datos

que simplemente sirve

a efectos de configuración de

algunas configuraciones.

Están guardadas en un, en este

caso un posible secuela,

pues porque es más cómodo que

guardarlo en triples

nada más para este, para este uso,

como pasa con todos los sistemas.

No todos los sistemas

sirven para todo.

De la misma manera.

Hay cosas más eficaces

que según el uso

y en este caso cuele Estado,

lo que sería la configuración de

las opciones de configuración

del sistema.

Tenemos una consulta de datos

que sirve a la web pública,

a la web pública,

a la parte de documentación ha

sido, tiene una web pública,

veremos luego claramente tiene

un servidor del Tata,

que es un servidor, que es poner

los datos enlazados

hacia fuera esto creo que lo veremos

en mayor detalle mañana

y tiene un parque elenco en que

es el punto de interrogación

que permite ejecutar consultas.

Es parqués, que son las consultas,

que admite un brazo de conocimiento

para que un usuario pueda explotar

la información.

El proceso de carga desde la sgae

y que es un poco ves es

un proceso básico.

Digamos, tiene estos pasos

que, como comentaba,

el sistema se pide los datos,

no hemos modificado su servicio

e interrogarle, Segi,

o hay un protocolo de una

organización que se llama

Open calcetines Satty que

es el protocolo.

Es un protocolo protocolo

para para cosechado

de metadatos, digamos, una

traducción así un poco libre,

es un protocolo muy utilizado y

simple, que es el que hemos

el que proponemos, como como interfaz

entre la fuente que se les

potencialmente Hércules,

pero podría ser, podría ser otro,

como veremos en el caso de la

implementación de Hércules,

que tenemos ahora de Hércules,

ha sido que tenemos ahora,

tenemos uno tedh que habla

contra un servicio

se que nos habéis proporcionado

desde la Universidad de Murcia.

No sé muy bien si estáis aquí

algunos de los implicados en este asunto,

pero, bueno, estamos conectados

con ese servicio

mediante un servicio.

El proceso de cargar recibe los

datos de la carga en un formato

XML que están definidos

por el pse-ee se hace

un proceso de validación de datos

contra la antología;

se convierten en rdc bueno,

aquí faltaría el paso de este que

nos estábamos comentando,

la recepción de los datos

y la convivencia en este paso de

validación y conversiones

cuando se llama a la

factoría de esto,

faltaría aquí en el punto

3, en el punto 4,

tenemos un descubrimiento del láser.

Reconciliación con datos existentes

y detección de equivalencias,

esto es hacer el descubrimiento.

Luego vemos un poco más en detalle

que sea un poquito más explicado

que hace esto.

Los datos se publican en el receptor

y se envían al nodo

que cuenta con sus propios procesos

de transformación y validación.

Este sería un poco el resumen de

cómo se cargan los los datos

o cómo se cargarán los

datos que llegan.

Componentes destacados

de la arquitectura,

tenemos la carga, de sido ahí

tenemos la factoría de Lloris

tenemos la validación descubrimiento

literata Server.

Y en cuanto a tecnología que

vamos a ir viendo un poco,

ahora vamos a ir viendo

estos componentes

destacados y acabaremos con un poco

un resumen de la tecnología,

el repositorio de software

y despliegues.

En cuanto a componentes destacados,

tenemos, en primer lugar, la

integración con hércules,

puede conectarse con

cualquier mensaje

y, preferentemente Hércules,

mediante peticiones al servicio

de NH.

El sistema permite también la

carga inicial de los datos,

tenemos la factoría de gris, esto

ya hemos ido comentando,

pero insistimos,

es clave en los datos que deben

generarse con formalmente correctos,

homogéneos y persistentes incluso

más allá de la vida,

se proyectó asientos.

Contamos con un documento

de buenas prácticas.

Contamos con la especificación del

esquema de Ulises Hércules,

que está inspirado en una norma

técnica de interoperabilidad

de reutilización de recursos

de la formación;

está publicada en el boe.

Tenemos una factoring, que adecuado

para cada tipo de entidad

sea si la entidad es un investigador,

la única de devuelve puede

ser parecida a esta.

Si es un área de conocimiento

sería parecida a esta.

Esto está en los documentos, en

estos documentos anteriores

y luego hemos preparado un

documento de adhesión

a las buenas prácticas de gris,

que de alguna manera debería

publicar cada 1.

Cada universidad es uno de

Blasio hacia fuera.

Esto digamos que es una de las

prácticas de ser de eta

que hemos comentado antes; es decir,

que de alguna manera la universidad

hasta el límite de sus medios,

garantice que los datos se adhieren

a un conjunto de buenas prácticas.

La validación, la variación se

efectúa mediante ceps saque,

esto es un estandarte del doble 13.

Básicamente es un lenguaje

para validar

contra un conjunto de condiciones.

Es decir, los datos llevan

y se válida,

pues que el dato, pues no

sé desde que una fecha

sea una fecha que, que un dato

a tiene que ser, único,

etc. Porque porque hace falta esto,

pues porque la extensiva unidad

del modelo de un modelo antológico

tiene una contrapartida

respecto a un modelo desarrollado

de una manera distinta,

como puede ser un sistema de tablas,

un modelo de tablas,

en un sistema relacional,

un sistema relacional,

el diseño de las de las de

las tablas, digamos,

que incorpora ciertas restricciones,

que no se pueden incumplir mientras

que en realidad él,

esto es un esquema.

Digamos que el modelo ecológico es

un esquema de datos más blando

que permitiría a cualquiera cargar

cualquier dato para evitar esto,

lo que se hace es uso de unas

valoraciones que son estas.

Estas valoraciones

se pueden relacionar con una

fuente de datos distinta,

porque podría pasar que

se obtuviera más

en una fuente de datos de distinta

naturaleza o calidad,

por ejemplo, una universidad

que no estuviera,

que no tuviera podría tener

los currículos,

podrían llegar desde un set,

desde un interfaz de ese,

mientras que la gestión podría

venir de otro sistema.

Bueno, los seis que tenemos aquí

se se generan automáticamente

a partir de las de las restricciones

de la red de antologías

-Hércules y el administrador cuenta

con herramientas para gestionarlos.

En cuanto al descubrimiento.

Digamos que el descubrimiento

a su vez

se divide en tres procesos,

que son reconciliación,

descubrimiento de enlaces y

detección de equivalencias; ya podéis disculpar

la repetición de descubrimiento

descubrimiento,

pero, bueno, esto está así desde

el principio del proyecto,

y nos sirve para saber a qué

no nos estamos refiriendo.

La reconciliación, que hace evitar

la duplicación de entidades

mediante un conjunto de reglas.

Tomar decisiones autónomas y la

evaluación de las reglas

supera un determinado umbral,

solicita la validación del usuario.

Si la evaluación, que en un

rango de duda digamos

bueno, imaginemos que que que llega

a un autor que es apuntó Merino

y podemos llegar a saber con

estas reglas que a punto

Merino coincide con un Antonio

Merino que ya está cargado en el sistema

o tal vez no.

Entonces, si el sistema con el

conjunto de reglas que tiene,

esta tiene la seguridad de que sea

punto, es Antonio Merino.

Lo que hace es reconciliar esos datos

y decir que una persona

es que la otra

y cargarlo una única vez si se

queda en un umbral de duda,

lo que va a hacer es mostrar esa

duda al uso de administrador.

Para que decida y si no

llega a ese umbral.

Es que no es la misma persona.

Para hacer esto

se utilizan datos que están

obtenidos en el descubrimiento de enlaces,

que es el siguiente paso

que vamos a ver

y es bueno.

Muchas fuentes externas, como

aquí doy etc y información

que pudiera estar en el

descubrimiento del láser

lo que hace es obtener

identificadores de fuentes externas,

obtiene información que usa

para la reconciliación,

y es un proceso de ejecución continua

que no se ejecuta solamente

en el proceso de carga,

es decir, se ejecuta también con

una cierta periodicidad,

porque la información en estos

repositorios externos

se ha podido actualizar desde

la última vez que se hizo

la carga.

El último proceso del descubrimiento

es la detección de equivalencias.

Si quieres obtener las cantidades y

otros no nos ha sido y es decir.

Imaginemos que yo he publicado en

la Universidad de Murcia de la

Universidad de La Rioja, La

Rioja tengo en Murcia,

tengo otro.

Entonces digamos que lo que hace

esto es alinear una entidad, detectar,

equivalencias entre la cesión para

que alguien pueda seguir,

digamos, puedan navegar desde el

nodo de la Universidad de La Rioja

y llegar al de Murcia, siguiendo

mi trabajo, digamos,

a través de.

De.

Y en una universidad llegará a

Yuri en otra universidad,

para esto se utilizan

la unidad y también

es una información que se

usa para el proceso,

para el primer proceso

de reconciliación.

Es decir, la reconciliación

digamos que trabaja

con los datos internos que ya

están cargados en Asia

trabaja con lo que,

con lo que se haya descubierto

enlaces en repositorios externos

y coloquio con lo que ha

encontrado en el vida,

otro componente importante

que tenemos,

el Cervélo Data Cervera,

es el componente que permite la

publicación de los datos que están

en el reloj.

Gestor, como datos abiertos

y enlazados, proporciona una

interfaz htc, que es con unos estilos

y formatos personalizables.

Esto veremos un poco y mañana

proporcionar los datos

también en formato PDF,

y serían para máquinas, digamos,

todo lo que son.

Son datos,

así como el primero, el html

es para una persona

lo que sería para una máquina

cumple con un estándar

que se le queda otra plazo y cuenta

con un servicio local

que permite localizar entidades

por el no.

Esto sería un ejemplo de de parte,

de los datos de un investigador

de la Universidad de Murcia.

La forma en que los datos se

presentan a un servidor

-ley que data tengamos que cumplir

unas ciertas convenciones

de que están que están aquí es decir,

si si fuera el servidor, que data de

otros sitios, por ejemplo, vería,

es una representación

bastante parecida

y luego también permite

representaciones un poco más ricas,

como puede ser una tabla

con artículos

como Graph o con sus relaciones.

Se recuerda en este punto lo que

os comentaba al principio,

que digamos que esto es

todo ese conjunto

de relaciones entre entidades.

Se puede expresar visualmente

un brazo; su conjunto

no tiene mucho sentido.

Esa representación visual,

porque abruma,

pero si nos vamos a un

único investigador,

pues bueno, aquí vemos,

por ejemplo, que

Antonio Fernández Skármeta Skármeta

tiene una relación directa con

estos investigadores,

con las líneas rojas y a su vez,

con las líneas grises,

demostrar las relaciones que los

investigadores tienen entre sí

porque tienen publicaciones en común.

Otro componente importante que es es

el interfaz que permite también

tantos series como máquinas.

Ejecutar consultas seis parques.

Es un protocolo de consulta y un

lenguaje de interrogación

para abrazos.

Corresponde a un estándar,

las siglas corresponden a un es un

son las siglas corresponden

a las el protocolo de lucha,

la versión 1,

punto uno de 2013, que pasa

como con ese Kohl,

que también hay versiones,

su lenguaje más nuevo

y tienen menos versiones.

Que se cuelen

y por lo menos en lugares públicos

será solamente lectura,

sea no permitir acceso a datos

a datos privados,

ni tampoco actualizaciones para

reutilizar datos que hay

que hacer.

Conocer el modelo de la

Red de Hércules,

saber hacer consultas, ayer

vimos unos con Álvaro

y utilizar el táser otro componente,

un componente básico

es el gestor que vamos a ver luego

un poco más en detalle ahora,

simplemente a modo de resumen, es

el componente de arquitectura

que almacenar conocimiento

de también es conocido

como servidores y redes o servidores.

Parker podréis verlo en algunos

otros algunas otras referencias técnicas,

porque porque al final pues

eso es un almacenamiento.

Pero también es un servidor de redes

y también habitualmente es el entorno

o el sistema que provee del interfaz,

es parque.

No voy a entrar aquí

porque luego la hora siguiente

vamos a hablar de esto,

entonces no lo dejamos

ahí Hércules Asia,

la arquitectura, se mantiene

una web documental

que permite publicar páginas que

informan de un contenido estático

y dinámico que se puede obtener

de la consulta que le pueden.

Se pueden desarrollar

páginas como estas,

que tienen datos de de que

se utilizan datos.

Tiene una buena administración que

permite hacer la administración

de los repositorios.

Seis validación gestionar la

factoría de obtener toques de acceso

a los Apis tienen unas

comprobaciones del sistema

y permitan y permite administrar

las páginas de la deuda.

Y ya por acabar vamos a hablar

un poco de la tecnología

y desarrollo.

En resumen, el desarrollo.

En su última versión ya permite

que los que los resultados

se desplieguen en Windows

y Linux o Mac

o ese sustituya es totalmente

multiplataforma,

y es está desarrollado o está

liberado con licencia,

que es una licencia propensos.

Nuestro desarrollo está hecho,

como con arquitectura;

es decir, son arquitectura

en servicios.

Nuestra idea es que sea más fácil

de mantener y reutilizar

los sapiens que hemos desarrollado.

Siguen el principio de comer tu

propia comida para perros,

es decir, unos una pieza

desarrollado a parte del programa,

sino que el programa la

aplicación usa lápiz

para funcionar de esa manera.

Garantizamos que el pie funcione

para ser reutilizado.

Este otro sistema.

Y bueno, ofrece un modo sencillo de

reutilización de los componentes

porque son básicamente una interfaz

con los verbos que postura, etc.

Y si bien es cierto que uno

de los componentes

de eso también se pueden reutilizar

como librerías en otros desarrollos,

pero no es lo que recomendaría

siempre,

de utilizarlo como un servicio,

el repositorio de software,

con la documentación está aquí

dentro del repositorio-pues bueno,

se hacen acciones de compilación

de sanitarios,

cobertura de código y calidad

de ese código consola.

Por último, respecto al despliegue,

que veremos más en detalle,

el las jornadas del jueves

y viernes tenemos

un proyecto así eso se puede

desplegar de todas formas

como conjunto de servicio y si esto

lo lo veremos el jueves,

y mediante imágenes, que

lo veremos el viernes,

la infraestructura básica, pues

máquinas, con máquinas web,

con Apache, un servidor para

tareas de Cofidis,

una red de una red de gestor que sea

compatible con el uno a punto 1,

un servicio base, relacional

por ejemplo,

se cuele y luego por último,

servicio de.

Para la gestión de colas,

de procesos,

y esto es en principio la tecnología

base que nos hace falta.

Con esto me pasa un poco

y yo ahora acabamos

con la presentación inicial.

No sé si aquí tenéis una duda, si

tenéis alguna duda al respecto

o no.

Disculpas por la transparencia

anterior,

la que emplea la tecnología.

Si puedes explicar las obras siempre

encima la otra vez,

sí a ver, a ver lo que serían

los servicios web,

las webs que tiene el sistema.

Se despliegan como servidores,

con máquinas web,

con Apache.

Necesita que tener un servidor.

Que tenga apache instalado.

Es un, pues puede ser un centro y no.

En principio esto es, no hay

ninguna restricción,

más allá de permitir

que esto funciona

y que, si instalamos lo que tiene

que permitir, necesitamos un servidor

Linux para instalar un conjunto de

servicios con tareas de acogida,

y si estas tareas que hemos

comentado antes

que están desarrolladas, los

procesos de sincronización,

que están en ejecución continua,

esto pueden estar en otra máquina,

también pudieran estar

en la misma máquina.

Pero bueno,

pensamos que puede ser mejor

hacer una separación.

Necesitamos nos han servido

el banco en que estaría?

Puede ser también, pues

yo también tul

y no sabe nada.

Ahí no necesita ningún

requisito específico

porque no necesita tampoco

apaches son son digamos

que son procesos que funcionan solos

como si sería el equivalente

a un servicio Guindos a una, a un,

a un lo que sería un que

esté corriendo el lino

o es algo así,

algo que está corriendo, que están

en ejecución continua.

Digamos que no, no están

en ni nada de esto.

Si no, no.

Esto está hecho, está hecho

el punto como correcto.

Gareth Bale.

Entonces, el despliegue es

un no sea un ejecutable

que necesita pues bueno sí sí sí sí

no se estaba cuando que necesita

tiene unos unos requisitos en cuanto

a la plataforma Microsoft,

que instalar.

Esto veremos en detalle el jueves,

pero si se instala.

Si el error de gestor sería el

sistema de base de datos

que arrojaría el Gafo,

esto en principio,

esto podría estar en

cualquier sistema,

que lo que lo permita, lo suyo es

que si toda la infraestructura

de Linux esto sea Linux y que,

bueno, pues luego veremos

cómo se selecciona esto,

porque aquí sí que hay

ciertos condicionantes que

pueden ser particulares,

de la universidad que hay

que tener en cuenta

de cada universidad.

Para eso es lo que hemos hecho,

que es lo que vamos a

ver a continuación,

que nos va a servir además para para,

para que conozcáis qué

características o que caracteriza

a una red de historia con respecto

a otros sistemas de base

de datos.

Porque sí que es cierto

que tienen peculiaridades,

que es lo que se dice,

que hay que pagarlo, las consultas,

si en este caso, en el entorno

de desarrollo,

mientras hemos estado desarrollando

el proyecto,

el servidor que hemos tenido

ha sido virtuoso,

es una red de gestor que

funciona sobre Linux,

eso está bien y hemos puesto ese,

pero podría ser otro siempre que

cumpla el estándar, hay 1,

hay una cosa que sí que es

un requisito, que es

que tiene que cumplir.

Es parcial, uno punto uno a

partir de ahí el resto,

pues bueno, puede ser,

hay matices, unos están,

no son software libre,

otros tienen licencia, algunos

están hechos en Java,

otros necesitan más memoria,

otros menos buenos.

Aquí es cuestión de de tomar una

decisión informada que necesita,

que es por lo que hemos hecho

el desarrollo de ese,

porque entendemos que es un

componente que para la mayor parte

de las universidades va

a ser muy novedoso,

porque es un componente raro.

Esto quitando los proyectos

de web semántica

que hay, como los que

hacemos nosotros,

o los que hacen otras empresas,

pues no es,

no es un producto de de

implantación masiva,

y las infraestructuras de las

organizaciones se usan,

pero pero esto necesita mucha,

necesita muchos muchos recursos,

pues saber de qué necesita

muchos recursos.

Si tienen muchos datos aquí el

asunto es que para funcionar bien en general

son bases de datos estos

en generales,

porque hay matices, necesitan

tener todo el rama,

como todo mundo necesitan tener

toda la base de entonces.

El requisito más fuerte es el

derrame más fuerte en relación

con otros sistemas, voces

y comparas con Oracle,

con ese suele ser ver con otros.

Las bases de datos de les digamos

que se comportan razonablemente

bien.

Sí si no tienen suficiente como para

tener toda la base de datos,

aunque funcionan mucho mejor.

Si tienen suficiente, como ya sabéis,

pues tanto se cuele ser como una vez,

que lo establecen un servidor,

ya te puedes olvidar

de estar otra cosa

porque adquieren toda la

arranque, pueden.

Aquí sin embargo en general

es un requisito,

veremos luego en el Best Mara

y ahí hay.

Una característica particular que le

llama el futuro es que te hace falta

para que funcione el sistema?

No?

Entonces.

En general luego claro,

comercialmente veremos lo

que cada sistema dice lo suyo en la

práctica hace falta suficiente

para que para que esto funcione

pero tampoco hay

que hay que asustarse mucho Llosa.

Supone que posee un sistema

como la sgae

y que podéis llegar a tener vosotros

en la universidad pasado,

ha sido que puede necesitar

16 gigas, 20 gigas,

una cosa así la consejera.

Bueno, el quinto componente

sería el servicio a base de base de

datos relacional que nosotros

hasta ahora lo hemos hecho con un

poso de secuela, pero bueno,

podría ser un país se cuele

o cualquier otra cosa

porque el uso es muy simple y

tenemos la gestión de colas

de colas de procesos rabieta

funcionaria sobre rabieta realidad

necesitamos muy poquitas muy pocas

para funcionar es muy rápido.

Entonces bueno, no, no es

un requisito pesado,

pero sí que conviene que

sea una máquina,

una máquina independiente.

Si entonces el rabillo que sería

como las escuelas una cosa parecida,

sí más o menos, estaría directamente

la máquina

o si en general una infraestructura

se iría 2, 3, cuatro o cinco máquinas

a ver si se puede decir que diría es.

Si tuviera que que saque al final

siempre tienes que jugar un poco

entre porque igual hay un componente

de base de datos

que pueden reutilizar que ya tienes,

porque la base de datos que necesita

siempre muy pequeña sea.

No me voy a casa, me la pongo yo,

les hubiese dado la pobreza,

puede ser bastante pequeña.

Si o sea, eso puedes montar

un servidor que tenga ya,

con lo cual, el componente

este te ahorras,

digamos un momento, es

aquí hay que verlo,

digamos que esto sería si sí

si lo tienes que poner,

completo, no, porque también

te puede pasar

que yo tenga unas máquinas web con

Pachi, Vázquez, después aquí

es que me cabe poner esto,

y lo pongas ahí

o no porque quieres tener la parte,

porque quieres tenerlo,

gestionado y monitorizado de una

manera dependiente, aquellas

un poco, digamos que que, que

depende de si no, las prácticas habituales,

como máquinas.

Tenemos Google, tenemos también

base de datos pobres.

Es decir, eso podemos reutilizar.

Entonces sí que sería el

servidor de Koffi,

sería un don.

Entiendo que eso sí que tiene

que ser un magno,

eso tiene que ser una máquina tiene

tiene limitaciones luego porque saber

el conviene dos dos cosas

nos adelantamos un poco

la jornada siguiente nos vamos a

los módulos que vienen ahora.

Conviene que tengan sepe o reservada,

que no es decir, éstos son bueno,

como pasa con con ese,

suele ser con Oracle, funciona mejor

sobre una infraestructura física

dedicada a infraestructuras,

que esté compartida, que la

acepte usted compartida,

porque a veces son muy

intensivos en cp, 1,

si la consulta es muy pesada o

muy compleja, no, entonces,

como has dicho que necesitaba

mucha memoria,

yo tenía claro que tendría

que estar una máquina,

una mayoría quiere éxito y corriendo,

sobre eso, bueno, también nosotros

tenemos por ahí;

instalaciones que ésta tiene una

visualización con reserva,

digamos que es una comedia.

Si también es con núcleos

concretos a perdonar,

y digo como Antonio que

vamos a decir,

aquí me tiene todo,

no voy a decir si va a ser un

hogar seguido balance,

y creo que esto y creo que entiende

que lo que está contando aquí habla

de uno o dos días hablando.

El modo específico de la universidad

y luego unidad a alguien,

donde estará la chicha.

Claro, porque conocerá

-donde se pone el paro, lo que pasa

es que está a ver un libro,

tan no se sabe dónde va a estar

finalmente inicialmente

inicialmente se supone que en el

prototipo está en Murcia,

pero no tiene más datos que el otro,

sea.

Es decir, los únicos datos que tiene

son los de la autopista Murcia,

pero bueno, que cuando

vayan creciendo,

si fuera creciendo,

si ahí había un éxito ahí había

un requisito mayor,

pues ahí necesitaría crecer, pues

probablemente tener una escala

y igual incluso tener un escalado

horizontal más

de una máquina,

porque hemos hecho un desarrollo

que permite hacer eso.

En fin, que eso ya hablamos

de otra arquitectura,

pero yo creo que esto vamos a ir

resolviendo durante con con más

información de lo que nos queda

de la jornada de hoy.

La jornada de mañana, algo menos,

pero sobre todo con la del jueves

y la del viernes,

que vamos a ver cómo se instala y

ahí pues pues ir haciendo una idea

de que, de que, de cómo traducir eso

a vuestra instalación concreta,

porque yo no me atrevo a decir cómo

tenéis que instalar vosotros,

porque no conozco cómo lo hacéis.

Entonces, no, vosotros

sois los que sabéis

cómo se organiza qué

tipo de máquinas,

como las distribuir y demás,

y sois los que tenéis que decidir

en función de este mapa lógico

como dices, estuvo josefa.

Pues qué es lo que hay que hacer

en concreto y ahora mismo

los servidores de o el montaje

que esté utilizando vosotros

no hay nada montada en la estructura,

sí si tenemos haber estado

en la infraestructura

de desarrollo,

hemos montado la que nos queda un

poquito para ponerla en marcha.

Yo, bueno, creo que hemos, tenemos

que pedir un dominio

porque para que las disfunciones

y todo esto funcione,

necesitamos que los dominios,

estén buenos y pero, bueno,

está creo que tenemos, tenemos

máquinas para un desarrollo

y quedaría luego, una vez que

hacer el de producción,

que eso ya, pues bueno, yo creo

que tenemos que hacerlo

con un proyecto conjunto entre

nosotros y nosotras.

Perdona Esteban, entonces hablando

con la parte en la que a mí me toca,

en el desarrollo, sólo

había un servidor,

se para pedido, hemos oído

que parase para separar el de unidad

del no de la Universidad,

vale, que son cosa de para conseguir.

Bueno, es ahora mismo, como digo,

va a tener los mismos datos,

pero podría tener una

por tener empleo,

una arquitectura más parecida

a lo que esperamos tener

en producción que aún no sabemos

exactamente lo que es.

Pero bueno, si no caerá

por sí a la hora

de hacer de producción se puede

elegir varios rsf,

minimizando la memoria

o los que sean.

Tienen que tener la misma negocia?

No sé si me he puesto, por

ejemplo, una media de 32

cuando tenía unos 32 gigantes,

pues voy a tener 2, 16 por si se cae,

esto depende de qué servidor rdc,

tengamos seis servidores,

redes que permiten trabajar

en, digamos,

en los que en el que los datos

están distribuidos

no están todos en un nodo,

y hay otros que no.

Entonces digamos que depende

un poco yo, yo,

cuando cuando sumaría otro nodo,

cuando necesitemos escalar para

mantener el rendimiento,

fuera es decir,

que hacia fuera no haya una un

único nuevo contestando,

sino que tengamos dos dos digamos,

ya habían escalado.

Ahí sería un escalador horizontal.

No sería tanto una distribución,

un jardín,

digamos que el parto, los datos,

y los distribuyó como que.

Un escalado.

Sí que en uno de esos proyectos que

hemos comentado anteriormente,

de los proyectos de Hércules, esma,

sí que hay comprometido una,

un un estudio al respecto

del escalado

de los datos del nodo central,

que incluye ya el Dafoe y otras

otras técnicas distintas,

digamos, yo diría que para el

nodo de la Universidad.

Lo más que puedo hacer falta

es tener más de un modo

para garantizar la disponibilidad,

por si se cae 1,

que los datos estén, pero digamos

que los dos no serían,

estarían con la misma memoria

y los mismos datos,

no que hubiera un reparto.

Podrían tener menos que tal vez

por si se reparten de otro,

pero, pero en principio es

lo que lo que diría,

lo que recomendaría para el paro

de una universidad de acuerdo.

Vale?

Pues.

Si me permite, voy a un minuto o 2;

voy a levantarme por un café

y vuelvo por si queréis

levantar a los otros

y hacer una pausa de acuerdo.